A különbség köztük Kis és nagy adatok

A Small Data nem más, mint az emberi erőforrás szempontjából elég kicsi, és formázási szempontból is elegendő adat, amely hozzáférhetővé, informatívvá és működőképessé teszi. A hagyományos adatfeldolgozás nem foglalkozhat nagy vagy összetett adatokkal, ezeket az adatokat nagy adatnak nevezik. Ha az adatmennyiség egy bizonyos határon túllépi, a hagyományos rendszerek és módszertanok nem elegendőek az adatok feldolgozásához vagy az adatok hasznos formátummá történő átalakításához. Ez az az oka annak, hogy az adatokat általában két kategóriába sorolják - kis adat vs nagy adat

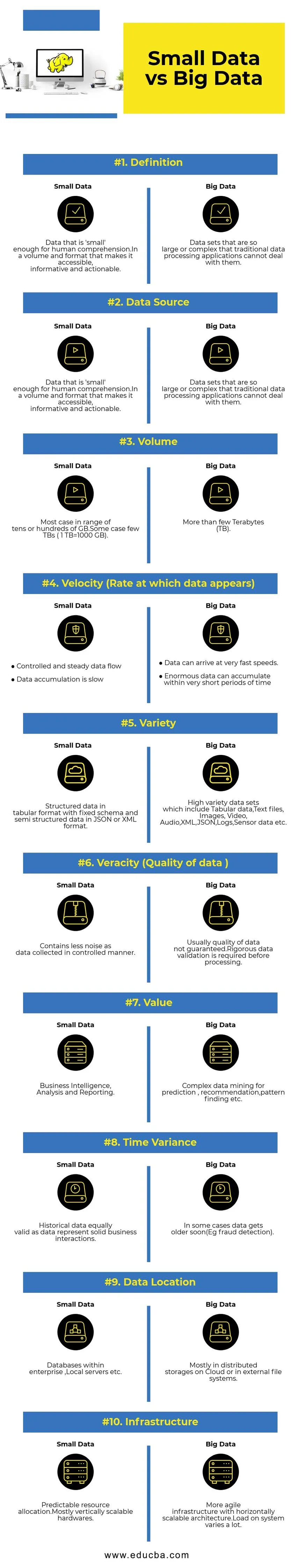

Összehasonlítás a kicsi és a nagy adat között (Infographics)

Az alábbiakban látható a 10 legfontosabb különbség a kis és a nagy adat között

A kis adatok és a nagy adatok közötti legfontosabb különbségek

- Adatgyűjtés - általában a Small Data az OLTP rendszerek része, és ellenőrzött módon gyűjtik, majd beillesztik a gyorsítótár rétegbe vagy az adatbázisba. Az adatbázisok replikákat olvasnak, hogy szükség esetén támogassák az azonnali elemzési lekérdezéseket. A nagy adatgyűjtési folyamatban olyan sorok lesznek, mint az AWS Kinesis vagy a Google Pub / Sub, hogy kiegyenlítsék a nagy sebességű adatokat. A Downstream streaming csővezetékeket fog valósidejű elemzéshez és kötegelt feladatokat készíteni a hideg adatfeldolgozáshoz.

- Adatfeldolgozás - Mivel a tranzakciós rendszeren keresztül generált kicsi adatok többsége, az ehhez kapcsolódó elemzések nagyrészt kötegorientáltak lesznek. Néhány ritka esetben az elemzési lekérdezések közvetlenül a tranzakciós rendszerek tetején futnak. A Big Data környezetek mind batch, mind stream feldolgozási folyamatokkal rendelkeznek. A patak valós idejű elemzésre szolgál, például hitelkártya-csalások észlelésére vagy részvényárak előrejelzésére. Kötegelt feldolgozás, amelyet komplex üzleti logika megvalósításához használnak adatokkal és fejlett algoritmusokkal.

- Skálázhatóság - A kis adatrendszerek általában függőlegesen méretezhetők . A függőleges méretezés növeli a rendszer kapacitását azáltal, hogy több erőforrást ad ugyanahhoz a géphez. A függőleges méretezés költséges, de kevésbé bonyolult kezelése. A nagy adatrendszerek többnyire a vízszintesen méretezhető architektúrától függenek, amely kevesebb költséggel nagyobb rugalmasságot biztosít. A felhőben elérhető, megelőző virtuális gépek a vízszintesen méretezhető rendszereket még megfizethetőbbé teszik.

- Adatmodellezés - A tranzakciós rendszerekből előállított kisméretű adatok normalizált formában lesznek. AzETL (Extract Transform Load) adatcsatornák csillag- vagy hópehelysémává alakítják át az adattárházban. Itt a sémát az adatok írásakor mindig érvényesítik, ami viszonylag egyszerű, mivel az adatok strukturáltabbak. Mint fentebb említettem, a táblázatos adatok a törzsadatok csak töredéke. Itt az adatokat sokkal többször is megismételik különböző okok miatt, például a hiba átadása vagy az alapul szolgáló adatbázis motor bizonyos korlátozása miatt (például egyes adatbázisok csak egy másodlagos indexet támogatnak adatkészletenként). Íráskor a séma nem érvényesül. Ehelyett a séma az adatok olvasása közben érvényesül.

- Tárolás és számítás összekapcsolása - A tradicionális adatbázisokban, amelyek többnyire kis adatot kezelnek, a tárolás és a számítás szorosan kapcsolódnak egymáshoz. Az adatok adatbázisba történő beillesztése és beolvasása csak az adott felületen keresztül lehetséges. Az adatokat nem lehet közvetlenül az adatbázis fájlrendszerbe helyezni, vagy a meglévő adatokat nem lehet lekérdezni más DB motorokkal. Valójában ez az architektúra nagyban hozzájárul az adatok integritásának biztosításához. A Big Data rendszereknek nagyon laza kapcsolódása van a tárolás és a számítás között. Az adatokat általában egy elosztott adattároló rendszerben tárolják, például HDFS, AWS S3 vagy Google GCS, és kiszámítják a motort az adatok lekérdezésére vagy egy későbbi időpontban kiválasztott ETL elvégzésére. Például, az interaktív lekérdezéseket a Presto (Link) és az ETL segítségével az Apache Hive segítségével végezhetjük el ugyanazon adatokkal.

- Adattudomány - A gépi tanulási algoritmusok bemeneti adatokat igényelnek jól strukturált és megfelelően kódolt formátumban, és a legtöbb esetben a bemeneti adatok mindkét tranzakciós rendszerből származnak, például egy adattárházból, és a Big Data tárolóból, mint egy adattó. Kizárólag a kicsi adatokon futó gépi tanulási algoritmusok egyszerűek lesznek, mivel az adatok előkészítési szakasza szűk. Az adatok előkészítése és gazdagítása a Big Data környezetben sokkal több időt vesz igénybe. A Big Data sok adatot kínál az adattudományi kísérletekhez a nagy mennyiségű és sokrétű adat miatt.

- Adatbiztonság - A kis adatokra vonatkozó biztonsági gyakorlatok, amelyek a vállalati adattárházakban vagy tranzakciós rendszerekben működnek, amelyeket megfelelő adatbázis-szolgáltatók biztosítanak, és amelyek tartalmazhatnak felhasználói jogosultságokat, adat titkosítást, kivonatolást stb. A nagy adatrendszerek biztonsága sokkal bonyolultabb és kihívásokkal telibb. A legjobb biztonsági gyakorlatok magukban foglalják az adatok titkosítását nyugalmi és átmeneti állapotban, a fürthálózat elkülönítését, az erőteljes hozzáférés-ellenőrzési szabályokat stb.

Kicsi és nagy adatok összehasonlító táblázata

| Az összehasonlítás alapja | Kis adatok | Nagy adat |

| Meghatározás | Olyan adatok, amelyek elég kicsik az emberi megértéshez. Olyan kötetben és formátumban, amely hozzáférhetővé, információs és működőképessé teszi őket | Olyan nagy vagy összetett adatkészletek, hogy a hagyományos adatfeldolgozó alkalmazások nem tudják kezelni őket |

| Adatforrás | ● Adatok a hagyományos vállalati rendszerekből, mint például ○ Vállalati erőforrás-tervezés ○ Ügyfélkapcsolat-menedzsment (CRM) ● Pénzügyi adatok, mint például a főkönyvi adatok ● A fizetési tranzakciók adatai a webhelyről | ● Vásárlási adatok az értékesítési helyről ● A webhelyek Clickstream adatai ● GPS adatfolyam - A szervernek elküldött mobilitási adatok ● Közösségi média - facebook, twitter |

| Hangerő | A legtöbb eset több tíz vagy száz GB-n belül van. Néhány esetben néhány TB (1 TB = 1000 GB). | Több mint néhány terabyte (TB) |

| Sebesség (az adatok megjelenési sebessége) | ● Szabályozott és állandó adatáramlás ● Az adatgyűjtés lassú | ● Az adatok nagyon gyors sebességgel érkezhetnek be. ● Nagyon sok adat halmozódhat fel nagyon rövid idő alatt |

| Fajta | Strukturált adatok táblázatos formátumban rögzített sémával és félig strukturált adatok JSON vagy XML formátumban | Nagyon sokféle adatkészlet, amely tartalmazza táblázatos adatokat, szöveges fájlokat, képeket, videót, audiót, XML-t, JSON-t, naplókat, érzékelőadatokat stb. |

| Valóságosság (az adatok minősége) | Kevesebb zajt tartalmaz, mint az ellenőrzött módon összegyűjtött adatok. | Az adatok minőségét általában nem garantáljuk. A feldolgozás előtt szigorú adatok érvényesítésére van szükség. |

| Érték | Üzleti intelligencia, elemzés és jelentéstétel | Komplex adatbányászat előrejelzéshez, ajánláshoz, mintakereséshez stb. |

| Idővariancia | A történeti adatok ugyanolyan érvényesek, mint az adatok szilárd üzleti interakciókat képviselnek | Egyes esetekben az adatok hamarosan elöregednek (pl. Csalások észlelése). |

| Adat helye | Adatbázisok egy vállalkozáson belül, helyi szerverek stb. | Leginkább felhőben elosztott raktárakban vagy külső fájlrendszerekben. |

| Infrastruktúra | Megjósolható erőforrás-elosztás. Legjobban vertikálisan skálázható hardver | Agilisabb infrastruktúra, vízszintesen méretezhető architektúrával. A rendszer terhelése nagyon változó. |

Következtetés - kis adat vs nagy adat

Az adatok elemzésének végső célja, hogy időben betekintést nyerjen a döntéshozatalba. Az adatok kis és nagy kategóriába sorolása segít megoldani a kihívásokat az egyes világok adatainak megfelelő eszközökkel történő külön-külön történő elemzése során. A két kategória közötti vonal változik a kialakuló fejlett adatfeldolgozó rendszerekkel, ami még a nagy adatok lekérdezését is sokkal gyorsabbá és kevésbé bonyolultvá teszi.

Ajánlott cikkek:

Ez egy útmutató a kis adatok és a nagy adatok, azok jelentésének, a fej-fej összehasonlítás, a legfontosabb különbségek, az összehasonlító táblázat és a következtetés összefoglalójához. ez a cikk tartalmazza a kis és nagy adatok közötti fontos különbségeket. A következő cikkeket is megnézheti további információkért -

- Big Data vs Data Science - miben különböznek egymástól?

- Big Data: Fontos a technológiai összefonódás és az üzleti elemzés

- Az öt legnagyobb adat-trend, amelyet a vállalatoknak elsajátítaniuk kell

- 16 érdekes tipp a nagy adatok nagy sikerhez való fordításához