Mi az Apache Hadoop ökoszisztéma?

Az Apache Hadoop Ecosystem egy keret vagy egy nyílt forrású adatplatform, amely a hatalmas adatgyűjtemények szerkezet nélküli mentésére és vizsgálatára van kijelölve. Az egész világon rengeteg adat hajt meg számos digitális platformon, a nagy adatok vezető innovatív technológiájával. Sőt, az Apache Hadoop volt az első, aki megkapta ezt az innovációs folyamatot.

Mit tartalmaz a Hadoop Data architektúra / ökoszisztéma?

A Hadoop ökoszisztéma nem programozási nyelv vagy szolgáltatás, hanem egy keret vagy platform, amely gondoskodik a nagy adatok kérdéséről. Azonosíthatja azt olyan csomagként, amely különféle szolgáltatásokat ölel fel, mint például a benne tárolás, lenyelés, karbantartás és elemzés. Ezután vizsgálja meg és tömören gondolkodjon azon, hogy a szolgáltatások miként működnek kizárólag és együttműködve. Az Apache Hadoop architektúrája különféle innovációkat és Hadoop elemeket tartalmaz, amelyek révén még a bonyolult információs kérdéseket is hatékonyan lehet megoldani.

Az alábbiakban bemutatjuk minden részét: -

1) Namenode: Az információ folyamatát irányítja

2) Datanode: Összeállítja az információkat a helyi tárolóba. Nem minden esetben javasoljuk, hogy az összes információt különálló helyre mentse, mivel az információ elvesztését okozhatja kiesési körülmények esetén.

3) Feladatkövető: A szolga csomóponthoz rendelt feladatokat kapják

4) Térkép: Információkat vesz egy adatfolyamból, és minden sort megosztva osztanak, hogy különféle mezőkbe osszák

5) Csökken: Itt a térképen megszerzett mezőket összegyűjtik vagy összekapcsolják

Apache Hadoop ökoszisztéma - lépésről lépésre

A Hadoop ökoszisztéma minden eleme, mint sajátos szempontok nyilvánvalóak. A Hadoop struktúrájának átfogó perspektívája figyelemre méltó minőséget kínál a Hadoop Distributed File Systems (HDFS), a Hadoop YARN, a Hadoop MapReduce és a Hadoop MapReduce számára a Hadoop ökoszisztémájából. A Hadoop minden Java könyvtárat, jelentős Java rekordokat, operációs rendszer szintű reflexiót, előnyöket és szkripteket ad a Hadoop működtetéséhez, a Hadoop YARN egy módszer az üzleti tevékenységek felvázolására és erőforrás-kezelésre. Hadoop konfigurációban a HDFS nagy áteresztőképességet biztosít az alkalmazási információkhoz, és a Hadoop MapReduce YARN alapú párhuzamos előkészítést nyújt széleskörű adatsortiment-ek készítéséhez.

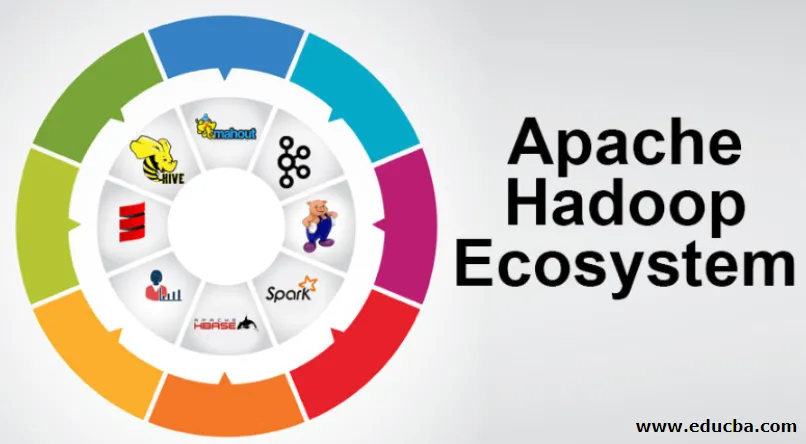

Az Apache Hadoop ökoszisztéma áttekintése

Alapvető kérdés, amelyet meg kell érteni, mielőtt elkezdené a Hadoop ökoszisztémával való munkát. Az alábbiakban bemutatjuk a lényeges elemeket:

- HDFS: Ez a Hadoop ökoszisztéma központi része, és óriási mennyiségű strukturálatlan, strukturált és félig strukturált információt képes megmenteni.

- Fonal: Ez hasonlít a Hadoop ökoszisztéma gondolkodására, és az összes kezelés közvetlenül itt zajlik, amely magában foglalhatja az eszközallokációt, az ütemezési feladatot és a cselekvés előkészítését.

- MapReduce: Ez a két folyamat keveréke, amelyeket Map és Reduce néven írnak le, és lényegében az alkatrészek előkészítését foglalja magában, amelyek hatalmas információs gyűjteményeket alkotnak, párhuzamos és szétszórt algoritmusok felhasználásával a Hadoop ökoszisztémán belül.

- Apache Pig: Ez az eljárás nyelve, amelyet párhuzamos kezelési alkalmazásokhoz hatalmas információgyűjtemények feldolgozására használnak Hadoop állapotban, és ez a nyelv egy opció a Java programozáshoz.

- HBase: Nyílt forráskódú és nem társított, vagy NoSQL adatbázis. Támogatja az összes információtípust, így bármilyen információtípushoz képes kezelni a Hadoop keretén belül.

- Mahout, Spark MLib: A Mahout gépi tanulásra használható, és természetessé teszi a gépi tanulási alkalmazások létrehozását.

- Állatkertőr: A csoportok kezeléséhez használhatjuk az Állatkertőröt, más néven a koordinációs uranak hívják, amely megbízható, gyors és rendezett operatív adminisztrációt nyújthat a Hadoop csokrok számára.

- Oozie: Az Apache Oozie a munka ütemezését működteti, és riasztási és óraszolgáltatásként működik a Hadoop ökoszisztémájában.

- Ambari: Az Apache Software Foundation vállalkozása, és fokozatosan rugalmasan képes végrehajtani a Hadoop ökoszisztémát.

Hadoop fonal:

Gondolj a FÁJRA, mint a Hadoop Ökoszisztéma elméjére. A teljes feldolgozási műveletet az eszközök és a tervezési feladatok hozzárendelésével játssza le.

Két figyelemre méltó szegmensből áll, amelyek a ResourceManager és a NodeManager.

- ResourceManager: - Ez ismét egy fő csomópont a működési részlegben. Megkapja az előkészítő kérdéseket, és ezt követően továbbítja a kérdéseket a NodeManagers-rel kapcsolatban, ahol valódi kezelés történik.

- NodeManagers: - Ezek telepítve vannak minden DataNode-ra. A feladat végrehajtása az egyes DataNode-okon.

Hogyan működik az apache Hadoop?

- Az a célja, hogy az egyes kiszolgálókról hatalmas mennyiségű gépre emelkedjen, amelyek mindegyike helyi kiszámítást és kapacitást biztosít. Ahelyett, hogy a nagy akadálymentességet közvetítő berendezéstől függne, magának a könyvtárnak az a célja, hogy megkülönböztesse és kezelje a csalódásokat az alkalmazás rétegén, így rendkívül hozzáférhető szolgáltatást közvetít egy csomó PC-n keresztül, amelyek mindegyike hajlamos csalódásokra.

- Nézzen tovább, és jelentősen növekszik a munka iránti varázsa. A Hadoop teljesen moduláris, ami azt jelenti, hogy gyakorlatilag bármely szegmensét kicserélheti egy alternatív szoftver eszközre. Ez az építészet fantasztikusan adaptálhatóvá teszi, ugyanolyan erős és hatékony.

Apache Hadoop Spark:

- Az Apache Spark egy valós idejű információelemzési rendszer szétszórt számítási beállításokban. A memóriában lévő számításokat hajt végre az információkezelés sebességének növelése érdekében.

- Gyorsabb a hatalmas információk kezelésének, mivel felhasználja a memóriában levő számításokat és a különböző fejlesztéseket. Ezek mellett nagy feldolgozási erőt igényel.

Hogyan működik az Apache Pig?

- Az Apache Pig egy hasznos rendszer, a Yahoo-t arra fejlesztették ki, hogy hatékonyan és zökkenőmentesen megvizsgálja a hatalmas információs helyzeteket. Néhány legfelső szintű információs adatfolyamnyelvet biztosít a Pig Latin számára, amely továbbfejlesztett, bővíthető és egyszerűen használható.

- A sertésprogramok kivételes összetevője, amelyben összetételük lényeges párhuzamosítást igényel, ezáltal egyszerűvé téve a lényeges információs gyűjtemények gondozását.

Pig felhasználási eset:

- Az egyének magán egészségügyi adatai privát jellegűek, ezért nem szabad azokat másoknak továbbadniuk. Ezeket az adatokat el kell rejteni a titoktartás fenntartása érdekében, ám a gyógyszolgáltatásokkal kapcsolatos információk hatalmasak ahhoz a pontig, hogy elengedhetetlen az egyéni egészségügyi információk felismerése és kizárása. Az Apache Pig ilyen körülmények között felhasználható az egészségügyi adatok felismerésére.

Következtetés:

- Feltételezzük, hogy csak egy kiszolgálóról hatalmas mennyiségű gépre emelkedik fel, amelyek mindegyike biztosítja a közeli számítást és kapacitást. Nézzen tovább, és a munkában egyre inkább elbűvölődik.

- A Hadoop teljesen moduláris, ami azt jelenti, hogy gyakorlatilag bármely alkatrészét ki tudja cserélni egy alternatív szoftver eszközre. Ezáltal a szerkezet fantasztikusan adaptálhatóvá válik, ugyanolyan erős és hatékony.

Ajánlott cikkek

Ez egy útmutató az Apache Hadoop Ecosystem rendszerhez. Itt megvitattuk, mi az Apache Hadoop ökoszisztéma? a Hadoop építészetének áttekintése és a Hadoop ökoszisztéma működése. A további javasolt cikkeken keresztül további információkat is megtudhat -

- Hadoop ökoszisztéma alkatrészek

- Az Apache telepítése

- Apache Spark Training

- Karrier a Hadoopban