Bevezetés a Hadoop keretrendszerbe

Mielőtt mélyebben belemerülnénk a Hadoop műszaki keretébe, egy egyszerű példával kezdjük.

Van egy olyan gazdaság, amely betakarítja és paradicsomot tárolja egyetlen raktárhelyiségben. A növekvő zöldségigény miatt a gazdaság burgonyát, sárgarépát kezdett betakarítani - egyre növekvő kereslettel hiányzott a gazdálkodók, így több gazdát béreltek fel. Néhány idő múlva rájöttek, hogy hiányzik a tárolóhelyiség - így a zöldségeket különféle tárolóhelyekre osztották szét. Az adatok visszakeresésekor mindegyik a saját tárhelyével párhuzamosan működik.

Tehát hogyan kapcsolódik ez a történet a nagy adatokhoz?

Korábban korlátozott adatok álltak rendelkezésre, korlátozott processzorral és egy tárolóegységgel. De azután az adatgeneráció növekedett, ami nagy mennyiségű és különböző változatossághoz vezetett - strukturált, félig strukturált és strukturálatlan -, tehát a megoldás az volt, hogy elosztott tárolót használjunk minden processzorhoz, ez lehetővé tette az adatok tárolására és elérésére való könnyű hozzáférést.

Tehát most a zöldségeket helyettesíthetjük különféle adat- és tárolási helyekként, mint az adatok tárolására szolgáló elosztott helyekként, és az egyes feldolgozók különféle dolgozói.

Tehát a nagy adatok jelentik a kihívást, és Hadoop játszik a megoldás részét.

Hadoop

1. Megoldás a BIG ADATOKHOZ: mivel a nagy mennyiségű, sebességű és sokféle adat összetettségével foglalkozik.

2. A nyílt forráskódú projekt halmaza.

3. Nagyon nagy mennyiségű adatot tárol megbízhatóan, és hatalmas elosztott számításokat tesz lehetővé.

4. A Hadoop kulcsfontosságú tulajdonságai a redundancia és a megbízhatóság (teljesen nincs adatvesztés).

5. Elsősorban a kötegelt feldolgozásra összpontosít.

6. Fut az alapanyagokon - nem kell külön drága hardvert vásárolnia.

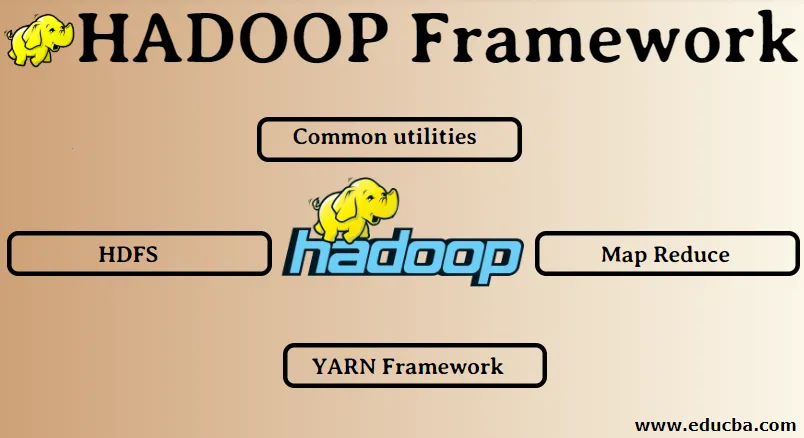

Hadoop-keretrendszer:

1. Közös közművek

2. HDFS

3. Térkép csökkentése

4. Fonal keret

1. Közös segédprogramok:

Hadoop néven is ismert. Ezek nem más, mint a JAVA könyvtárak, fájlok, szkriptek és segédprogramok, amelyeket a Hadoop többi összetevőjének valóban végrehajtásához szükség van.

2. HDFS: Hadoop elosztott fájlrendszer

Miért döntött a Hadoop egy elosztott fájlrendszer beépítésével?

Megértjük ezt egy példával: 1 TB adatot kell elolvasnunk, és van egy gépünk 4 I / O csatornával, mindegyik csatorna 100 MB / s sebességgel rendelkezik, az összes adat elolvasása 45 percbe telt. Most ugyanannyi adatot olvas be 10 gép, mindegyik 4 I / O csatornával, mindegyik csatorna 100 MB / s sebességgel. Találd ki, mennyi időbe telt az adatok elolvasása? 4, 3 perc. A HDFS megoldja a nagy adatok tárolásának problémáját. A HDFS két fő alkotóeleme a NAME NODE és DATA NODE. A névcsomópont a mester, akkor lehet egy másodlagos névcsomópont is, ha az elsődleges névcsomópont nem működik, a másodlagos névcsomópont biztonsági másolatként működik. A névcsomópont alapvetően a metaadatok tárolásával kezeli és kezeli az adatcsomópontokat. Az adatcsomó a rabszolga, amely alapvetően az olcsó árucikk-hardver. Több adatcsomópont is lehet. Az adatcsomópont a tényleges adatokat tárolja. Ez az adatcsomópont támogatja a replikációs tényezőt. Tegyük fel, hogy ha az egyik adatcsomópont leesik, akkor az adatokhoz a másik replikált adatcsomópont is hozzáférhet, tehát javul az adatok hozzáférhetősége és megakadályozzuk az adatok elvesztését.

3. Térkép csökkentése:

Megoldja a nagy adatok feldolgozásának problémáját. Megértjük a térkép fogalmának csökkenését a valós probléma megoldásával. Az ABC vállalat városi szempontból kiszámítja az összes eladását. Most a hash table koncepció nem fog működni, mert az adatok terabyte-ban vannak, tehát a Map-Reduce koncepciót fogjuk használni.

Két szakasz van: a) MAP. b) CSÖKKENTÉS

a) Térkép : Először az adatokat kisebb / nagy részekre osztjuk fel, amelyeket térképíróknak hívnak, a kulcs / érték pár alapján. Tehát itt a kulcs a város neve lesz, és az érték az összes eladás. Minden térképkészítő megkapja minden hónap adatait, amelyek megadják a város nevét és a megfelelő eladásokat.

b) Csökkent: Megkapja ezeket az adathalmokat, és minden reduktor felel az észak / nyugat / kelet / dél városokért. Tehát a reduktor munkája az lesz, hogy összegyűjtse ezeket a kis darabokat, és nagyobb összegekké alakítsa át (összeadva) egy adott város számára.

4.YARN-keret: újabb erőforrás-tárgyaló.

A Hadoop kezdeti verziója csak két összetevőből állt: Map Reduce és HDFS. Később rájött, hogy a Map Reduce nem képes sok nagy adatproblémát megoldani. Az ötlet az volt, hogy az erőforrás-gazdálkodással és a feladatok ütemezésével kapcsolatos felelősséget távolítsa el a régi térképcsökkentő motortól, és adjon neki egy új összetevőt. Tehát így került a képbe a YARN. A fürt erőforrásainak kezelése a középső réteg a HDFS és a Map Reduce között.

Két kulcsszerepet tölt be: a) Munkaütemezés. b) Erőforrás-menedzsment

a) Munkaütemezés: Ha nagy mennyiségű adat ad feldolgozásra, akkor azokat el kell osztani és különféle feladatokra / feladatokra bontani. Most a JS dönt arról, hogy melyik munkát kell elsőbbséget élvezni, a két feladat közötti időintervallum, a munkák közötti függőség, és ellenőrzi, hogy nincs-e átfedés a futó feladatok között.

b) Erőforrás-kezelés: Az adatok feldolgozásához és az adatok tárolásához erőforrásokra van szükségünk? Az erőforrás-kezelő tehát biztosítja, kezeli és karbantartja az adatok tárolására és feldolgozására szolgáló erőforrásokat.

Tehát most már tisztában vagyunk a Hadoop koncepciójával és azzal, hogy hogyan oldja meg a NAGY ADATOK által létrehozott kihívásokat !!!

Ajánlott cikkek

Ez egy útmutató a Hadoop-keretrendszerhez. Itt megbeszéljük a Hadoop négy legfontosabb keretét is. A további javasolt cikkeken keresztül további információkat is megtudhat -

- Hadoop adatbázis

- Hadoop ökoszisztéma

- A Hadoop felhasználásai

- Hadoop rendszergazdai munkák

- Hadoop rendszergazda | Készségek és karrier út