Bevezetés az adatok előfeldolgozásához a gépi tanulásban

Az adatok előfeldolgozása a gépi tanulásban egy módszer arra, hogy az adatokat a nyers formából sokkal formázottabb, használhatatlanná vagy kívánt formává konvertáljuk. A gépi tanulás szerves feladata, amelyet az adattudós végez. Mivel az összegyűjtött adatok nyers formátumban vannak, előfordulhat, hogy nem lehet megvalósítani a modell edzését annak felhasználásával. Fontos, hogy ezeket a nyers adatokat gondosan feldolgozzuk, hogy megfelelően értelmezhessük és végül elkerüljük az előrejelzés negatív eredményeit. Röviden: tanulási algoritmusunk minősége nagymértékben függ attól, hogy milyen adatkészlettel tápláltuk be a modellt, tehát az adatok előfeldolgozását használjuk e minőség fenntartására.

A modell képzéséhez gyűjtött adatok különböző forrásokból származnak. Ezek az összegyűjtött adatok általában nyers formátumban vannak, azaz lehetnek olyan zajok, mint például hiányzó értékek, és releváns információk, számok karakterláncformátumban stb., Vagy strukturálatlanok is. Az adatok előfeldolgozása növeli a gépi tanulási modellek hatékonyságát és pontosságát. Mivel segít eltávolítani ezeket a zajokat és az adatkészletet, és értelmet ad az adatkészletnek

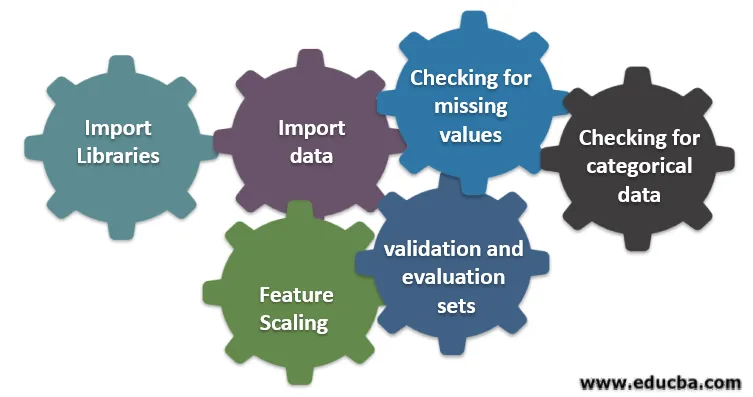

A gépi tanulásban részt vevő hat különböző lépés

Az alábbiakban bemutatunk hat különböző lépést a gépi tanulásban az adatok előfeldolgozása érdekében:

1. lépés: Könyvtárak importálása

2. lépés: Adatok importálása

3. lépés: A hiányzó értékek ellenőrzése

4. lépés: kategorikus adatok ellenőrzése

5. lépés: A szolgáltatás méretezése

6. lépés: Az adatok felosztása képzési, érvényesítési és értékelési halmazokba

Megértjük a következő lépések részleteit:

1. Importálja a könyvtárakat

Az első lépés az adatok előfeldolgozásához szükséges néhány fontos könyvtár importálása. A könyvtár olyan modulok gyűjteménye, amelyek hívhatók és felhasználhatók. A pythonban nagyon sok könyvtár található, amelyek segítenek az adatok előfeldolgozásában.

A python következő fontos könyvtárainak kevés a következő:

- Numpy: Leginkább a könyvtárat használták a gépi tanulás bonyolult matematikai számításának végrehajtásához vagy felhasználásához. Hasznos művelet végrehajtása többdimenziós tömbökön.

- Pandas : Ez egy nyílt forráskódú könyvtár, amely nagy teljesítményt nyújt, és a pythonban könnyen használható adatszerkezetet és elemző eszközöket kínál. Úgy tervezték, hogy a kapcsolat és a címkézett adatokkal való munka egyszerű és intuitív legyen.

- Matplotlib: Ez egy megjelenítési könyvtár, amelyet python biztosít 2D grafikonokhoz vagy tömbhöz. Ez egy hamis tömbre épül, és egy szélesebb Scipy veremhez való működésre tervezték. Az adatkészletek megjelenítése hasznos abban az esetben, ha nagy adatok állnak rendelkezésre. A Matplot lib-ben elérhető grafikonok vonal, sáv, szórás, hisztogram stb.

- Seaborn: Ez egy vizuális könyvtár, amelyet Python ad. Magas szintű felületet biztosít vonzó és informatív statisztikai grafikonok készítéséhez.

2. Import adatkészlet

A könyvtárak importálása után a következő lépésünk az összegyűjtött adatok betöltése. A pandák könyvtárat használják ezen adatkészletek importálására. Az adatkészletek leginkább CSV formátumban érhetők el, mivel kicsi, ami megkönnyíti a feldolgozást. Tehát egy csv fájl betöltése a panda könyvtár read_csv függvényével. Az adatkészlet számos egyéb formátuma látható

Miután az adatkészlet betöltődött, meg kell vizsgálnunk és meg kell keresnünk minden zajt. Ehhez létre kell hoznunk egy X jellemző mátrixot és egy Y megfigyelési vektort X-hez viszonyítva.

3. Hiányzó értékek ellenőrzése

A szolgáltatás mátrix létrehozása után előfordulhat, hogy vannak hiányzó értékek. Ha nem kezeljük, akkor problémát okozhat az edzés idején.

A hiányzó értékek kezelésére két módszer van:

- A hiányzó értéket tartalmazó teljes sor eltávolítása, de előfordulhat, hogy elveszít néhány lényeges információt. Ez jó megközelítés lehet, ha az adatkészlet mérete nagy.

- Ha egy numerikus oszlopban hiányzik az érték, akkor az értéket becsülheti meg az átlag, a medián, az üzemmód stb. Alapján.

4. kategorikus adatok ellenőrzése

Az adatkészletben szereplő adatoknak numerikus formában kell lenniük, hogy rajtuk kiszámítsák. Mivel a gépi tanulási modellek komplex matematikai számítást tartalmaznak, nem számszerű értéket adhatunk nekik. Fontos tehát, hogy az összes szöveges értéket numerikus értékre konvertáljuk. A LabelEncoder () osztálya megtanulja ezeket a kategorikus értékeket numerikus értékekké.

5. A szolgáltatás méretezése

A nyers adatok értékei rendkívül eltérőek, és a modell elfogult képzését eredményezhetik, vagy pedig növekedhetnek a számítási költségek. Ezért fontos normalizálni őket. A szolgáltatás méretezése egy olyan módszer, amelyet arra használnak, hogy az adat értékét rövidebb tartományba hozzák.

A jellemzők méretezéséhez használt módszerek a következők:

- Átméretezés (min-max normalizálás)

- Átlagos normalizáció

- Szabványosítás (Z-pontszám normalizálása)

- Méretezés az egységhosszra

6. Az adatok felosztása képzési, érvényesítési és értékelési halmazokba

Végül adatainkat három különféle készletre kell bontani: a modell kiképzésére szolgáló képzési halmazra, a modell pontosságának érvényesítésére szolgáló validációs halmazra, végül tesztkészletre, hogy modellünk teljesítményét általános adatokra teszteljük. Az adatkészlet felosztása előtt fontos az adathalmaz eloszlatása az esetleges torzulások elkerülése érdekében. Az adatkészlet felosztásának ideális aránya 60:20:20, azaz 60% edzéskészletként, 20% teszt- és validációs készletként. Az adatkészlet felosztásához használja kétszer a sklearn.model_selection vonat_test_split értékét. Egyszer az adatkészletet fel kell osztani a vonatra és az érvényesítési halmazra, majd a fennmaradó vonat adatkészletet fel kell osztani a vonatra és a tesztkészletre.

Következtetés - Adat előfeldolgozása a gépi tanulásban

Az adat előfeldolgozása gyakorlatot igényel. Ez nem olyan egyszerű adatszerkezet, amelyben megtanulja és közvetlenül alkalmazza a probléma megoldására. Ahhoz, hogy megismerje az adatkészlet tisztítását vagy az adatkészlet megjelenítését, különféle adatkészletekkel kell dolgoznia.

Minél többet fogja használni ezeket a technikákat, annál jobb megértést fog kapni róla. Ez általános elképzelés volt arról, hogy az adatfeldolgozás fontos szerepet játszik a gépi tanulásban. Ezzel párhuzamosan láttuk az adatok előfeldolgozásához szükséges lépéseket is. Tehát legközelebb, mielőtt elkezdené a modell kiképzését az összegyűjtött adatokkal, ügyeljen az adatok előfeldolgozására.

Ajánlott cikkek

Ez egy útmutató az adatok előfeldolgozásához a gépi tanulásban. Itt tárgyaljuk a gépi tanulásban részt vevő hat különböző lépés bevezetését. A további javasolt cikkeken keresztül további információkat is megtudhat -

- A mesterséges intelligencia fontossága

- IoT technológia

- PL / SQL adattípusok

- Kaptár adattípusai

- R adattípusok