Bevezetés a kernel módszerekbe a gépi tanulásban

A mintanalízishez használt algoritmust Kernel Method-nek nevezik a Machine Learning-ben. Általánosságban az elemzést az adatkészletek közötti kapcsolatok megtalálására végezzük. Ezek a kapcsolatok lehetnek klaszterezés, osztályozás, fő összetevők, korreláció stb. A mintázat elemzésének ezen feladatait megoldó algoritmusok többsége: Az adatoknak nyers reprezentatív formában kell lenniük, hogy kifejezetten átalakítsák a jellemzővektor ábrázolássá. Ez az átalakítás elvégezhető egy felhasználó által megadott jellemzőtérképen. Tehát feltételezhető, hogy csak a felhasználó által megadott kernelre van szükség a kernel módszerhez.

A Kernal módszer terminológia abból a tényből származik, hogy a rendszermag funkciót használják, amely lehetővé teszi számukra a művelet elvégzését nagydimenziós, implicit funkciójú térben anélkül, hogy meg kellene számolniuk az adott téren lévő adatok koordinátáit. Ehelyett egyszerűen kiszámítják a belső terméket az objektumtérben lévő összes adatpár képei között.

Az ilyen típusú műveletek számítástechnikai szempontból olcsóbbak, a koordináták kifejezett kiszámításához képest. Ezt a technikát „kernel-trükknek” nevezik. Bármely lineáris modell konvertálható nemlineáris modellré, ha a rendszermag-trükköt alkalmazzuk a modellre.

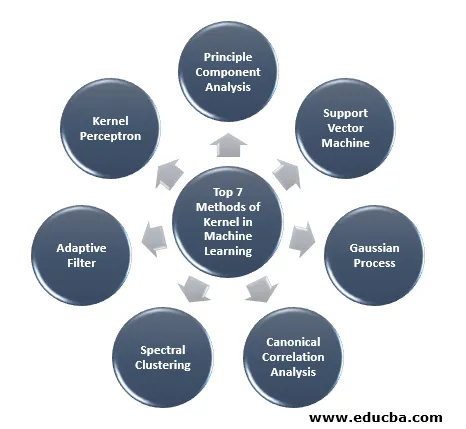

A gépi tanulásban elérhető kernel módszer a fő komponensek elemzése (PCA), spektrális klaszterezés, támogató vektor gépek (SVM), kanonikus korrelációs elemzés, kernel perceptron, Gauss folyamatok, gerinc regresszió, lineáris adaptív szűrők és még sok más. Legyen magas szintű megértés néhány ezekből a kernelmódszerekből.

A kernel 7 legfontosabb módszere a gépi tanulásban

Az alábbiakban említjük a kernel módszerét a gépi tanulásban:

1. Az alapelem elemzése

A főkomponens-elemzés (PCA) egy olyan módszer, amellyel kivonhatják a struktúrát az esetleges nagydimenziós adatkészletekből. Könnyen elvégezhető az iteratív algoritmusok felhasználásával, amelyek megbecsülik a fő komponenseket, vagy megoldva van egy sajátérték-probléma. A PCA a koordinátarendszer ortogonális transzformációja, amelyben leírjuk az adatainkat. Az új koordinátarendszert az adatok fő tengelyére vetítés útján állítják elő. Gyakran elegendő néhány főbb összetevő, hogy figyelembe vegyék az adatok szerkezetének nagy részét. Ennek egyik fő alkalmazási területe feltáró adatok elemzése prediktív modell elkészítéséhez. Leginkább a populációk és a genetikai távolság közötti összefüggések megjelenítésére használták.

2. Támogassa a vektorgépet

Az SVM meghatározható osztályozóként a hiper sík elválasztására, ahol a hiper sík egy dimenzió alterülete kisebb, mint a környezeti tér. Ennek a matematikai térnek a mérete a minimális koordináták száma, amely bármely pont meghatározásához szükséges, míg a környezeti tér a matematikai objektumot körülvevő tér. Most a matematikai objektumot olyan absztrakt objektumként lehet értelmezni, amely semmilyen helyen vagy helyen nem létezik, hanem egyfajta dologként létezik.

3. Gauss-folyamat

A Gauss-féle folyamatot Cark Friedrich Gauss-nak nevezték el, mert a Gauss-eloszlás (normál eloszlás) jelölését használja. Ez egy sztochasztikus folyamat, amely véletlenszerű változók gyűjteményét jelenti idő vagy tér indexálásával. A Gauss-folyamatban a véletlenszerű változók többváltozós normál eloszlással rendelkeznek, azaz az összes véges lineáris kombinációja normálisan eloszlik. A Gauss-féle folyamat a normál eloszlásból örökölt tulajdonságokat használja, ezért hasznos a statisztikai modellezés során. A gépi tanulás algoritmusa, amely magában foglalja ezt a kernel-módszert, a lusta tanulás mértékét és a pontok közötti hasonlóságot használja az előre nem látható pontok értékének előrejelzésére az edzési adatok alapján. Ez az előrejelzés nemcsak a becslés, hanem a bizonytalanság is.

4. Kanonikus korrelációs elemzés

A kanonikus korrelációs elemzés egy módszer arra, hogy információt vonjunk le a keresztkovariancia mátrixokból. Kanonikus változók elemzéseként is ismert. Tegyük fel, hogy van két X, Y vektor véletlenszerű változóval, mondjuk két vektor X = (X1, …, Xn) és Y vektor (Y1, …, Ym), és a változó korrelációval rendelkezik, akkor a CCA kiszámítja X lineáris kombinációját és Y, amelyek között a maximális korreláció van.

5. Spektrális klaszter

A képszegmentálás alkalmazásában a spektrális csoportosítást szegmentálás-alapú objektum-kategorizálásnak nevezzük. A spektrális klaszterezésnél a dimenzió csökkentését a kevesebb dimenzióba történő csoportosítás előtt hajtjuk végre, ezt az adatok hasonlósági mátrixának sajátértékének felhasználásával hajtjuk végre. A gráf elméletében gyökerezik, ahol ezt a megközelítést használják a csomópont közösségek azonosítására egy gráfban, amely az őket összekötő élek alapján épül fel. Ez a módszer elég rugalmas és lehetővé teszi számunkra, hogy az adatokat a nem gráfból is csoportosítsuk.

6. Adaptív szűrő

Az adaptív szűrő egy lineáris szűrőt használ, amely átváltási funkciót tartalmaz, amelyet változó paraméterek vezérlnek, és azokat a módszereket, amelyek ezen paraméterek optimalizálási algoritmus szerint történő finomítására szolgálnak. Ennek az optimalizáló algoritmusnak a bonyolultsága oka annak, hogy minden adaptív szűrő digitális szűrő. Adaptív szűrőre van szükség azokban az alkalmazásokban, ahol nincs előre rendelkezésre álló információ a kívánt feldolgozási műveletről, vagy ezek megváltoznak.

A költségfüggvényt a zárt hurkú adaptív szűrőben használják, mivel ez a szűrő optimális teljesítményéhez szükséges. Meghatározza, hogyan kell módosítani a szűrőátviteli funkciót a következő iteráció költségeinek csökkentése érdekében. Az egyik leggyakoribb funkció a hibajel átlagos négyzetes hibája.

7. Kernel Perceptron

A gépi tanulás során a kernel perceptron egy olyan népszerű perceptron tanulási algoritmus típusa, amely képes megtanulni a kernel gépeit, például nemlineáris osztályozók, amelyek kernel függvényt használnak arra, hogy kiszámítsák azoknak a mintáknak a hasonlóságát, amelyek nem láthatók a minták kiképzéséhez. Ezt az algoritmust 1964-ben fedezték fel, és ez volt az első kernel besorolási tanuló.

A megvitatott kernel algoritmusok többsége konvex optimalizáláson vagy sajátproblémákon alapul, és statisztikailag megalapozottak. Statisztikai tulajdonságaikat a statisztikai tanulási elmélet segítségével elemezzük.

A kernel módszerek alkalmazási területeiről beszélve sokrétű, és magában foglalja a geosztatisztikát, a kriging-et, az inverz távolság súlyozását, a 3D rekonstrukciót, a bioinformatikát, a kemoinformatikát, az információ kinyerését és a kézírás felismerését.

Következtetés

Összefoglaltam a Machine Learning néhány terminológiáját és típusát. A helyhiány miatt ez a cikk semmiképpen sem átfogó, csupán arra szolgál, hogy megértsük, mi a kernel módszer, és rövid ismertetést adjunk azok típusairól. Ennek a cikknek a lefedése ugyanakkor megteszi az első lépést a gépi tanulás területén.

Ajánlott cikkek

Ez egy útmutató a kernel módszerhez a gépi tanulásban. Itt tárgyaljuk a gépi tanulás kernel-módszerének 7 típusát. A következő cikket is megnézheti.

- Monolit kernel

- Fürtözés a gépi tanulásban

- Adattudományi gépi tanulás

- Nem felügyelt gépi tanulás

- PHP szűrők | Hogyan validálhatjuk a felhasználói bemeneteket különféle szűrőkkel?

- Teljes útmutató a gépi tanulás életciklusához