Bevezetés a Big Data architektúrába

A nehéz adatok kezelése és az ezen a hatalmas adatokon végzett komplex műveletek elvégzésekor szükség lesz nagy adat eszközök és technikák használatára. Amikor azt mondjuk, hogy nagy adattárgyú eszközök és technikák használják, akkor azt értjük, hogy különféle szoftverek és eljárások használatát kérjük, amelyek a nagy adatökoszisztémában és annak szférájában rejlenek. Nincs általános megoldás, amelyet minden felhasználási esetre rendelkezésre bocsátanak, ezért azt egy adott vállalat üzleti igényei szerint hatékonyan kell kidolgozni és elkészíteni. Így szükségessé válik a különféle nagy adatok architektúrájának használata, mivel a különféle technológiák kombinációja eredményeként a felhasználási esetet elérik. Rögzített architektúra létrehozásával biztosítható, hogy életképes megoldást találjanak a kért felhasználási esetre.

Mi a Big Data Architecture?

- Ezt az architektúrát úgy tervezték meg, hogy kezeli a beviteli folyamatot, az adatok feldolgozása és az adatok elemzése megtörténjen, ami túl nagy vagy összetett ahhoz, hogy a hagyományos adatbázis-kezelési rendszereket kezelje.

- A különböző szervezeteknek eltérő küszöbértéke van a szervezeteiknek, másoknak néhány száz gigabájtot kell elérniük, másoknak pedig néhány terabyte nem elég jó küszöbértéket.

- Ennek az eseménynek a következtében, ha megnézzük az árucikkeket és az áru tárolását, az értékek és a tárolás költségei jelentősen csökkentek. Nagyon sokféle adat áll rendelkezésre, amelyek ellátásának különféle módjaira van szükség.

- Néhányuk kötegelt adatok, amelyek egy adott időpontban érkeznek, és ezért a feladatokat hasonló módon kell ütemezni, míg mások a streaming osztályba tartoznak, ahol valós idejű streaming csővezetéket kell építeni, hogy minden követelményeknek. Mindezeket a kihívásokat a nagyadat-architektúra oldja meg.

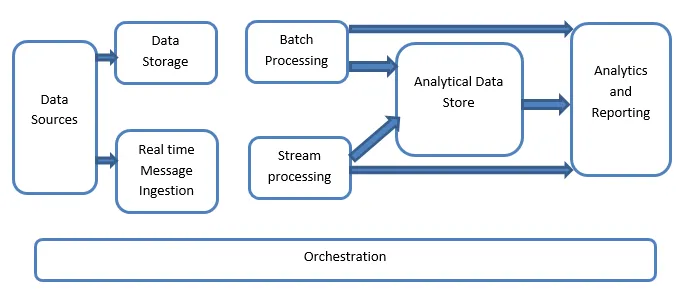

A Big Data Architecture magyarázata:

A nagy adatrendszerek egynél több munkaterhelést foglalnak magukban, és általánosságban az alábbiak szerint vannak besorolva:

- Ahol a nagy adat-alapú források nyugalomban vannak, a kötegelt feldolgozást végzik.

- Nagy adatfeldolgozás mozgásban a valós idejű feldolgozáshoz.

- Interaktív nagy adat eszközök és technológiák feltárása.

- Gépi tanulás és prediktív elemzés.

1. Adatforrások

Az adatforrások mindazon arany forrásokat magukba foglalják, ahonnan az adatkitermelő csővezeték épült, ezért ez a nagy adatvezeték kiindulópontja lehet.

A példák között szerepel:

(i) Az alkalmazások adatállományai, mint például a relációs adatbázisok

(ii) A számos alkalmazás által előállított fájlok, amelyek nagyrészt a statikus fájlrendszerek részét képezik, például a naplókat generáló webes kiszolgáló fájlok.

iii. tárgyak internete eszközök és egyéb valósidejű adatforrások.

2. Adattárolás

Ez magában foglalja az adatokat, amelyeket a kötegelt készítésű műveletekhez kezelnek, és amelyeket a természetben elosztott fájl tárolókban tárolnak, és képesek nagy mennyiségű, különféle formátumú, nagy hátterű fájlt tárolni. Adat-tónak hívják. Ez általában azt a részét képezi, ahol a Hadoop tárolójainkat, például HDFS, Microsoft Azure, AWS, GCP tárolókat blob-tárolókkal együtt biztosítjuk.

3. Kötegelt feldolgozás

Az összes adat különféle kategóriákba vagy darabonként van elkülönítve, amely hosszú távú feladatokat használ fel a szűréshez és az összesítéshez, valamint az adatok előkészítéséhez az elemzéshez. Ezek a feladatok általában forrásokat használnak, feldolgozzák, és a feldolgozott fájlok kimenetet biztosítják az új fájlokhoz. A kötegelt feldolgozást különféle módokon hajtják végre a Hive jobok vagy U-SQL alapú jobok felhasználásával, vagy a Sqoop vagy Pig alkalmazásával, valamint az egyedi térképcsökkentő jobokkal, amelyek általában a Java vagy a Scala bármelyikében vannak írva, vagy bármely más olyan nyelv, mint a Python.

4. Valósidejű üzenetbevitel

Ez magában foglalja a kötegelt feldolgozással ellentétben azokat a valós idejű streaming rendszereket, amelyek gondoskodnak a szekvenciálisan és rögzített mintában előállított adatokról. Ez gyakran egy egyszerű adatkezelő vagy tároló, amely felelős az összes bejövő üzenetért, amelyek a mappába esnek, és amelyet szükségszerűen az adatfeldolgozáshoz használnak. Vannak azonban olyan megoldások többsége, amelyek megkövetelik egy üzenet-alapú lenyelési tároló szükségességét, amely üzenetpufferként működik, és támogatja a méretarányos feldolgozást is, viszonylag megbízható kézbesítést biztosít a többi üzenetkezelő sorba állító szemantika mellett. A lehetőségek között szerepel az Apache Kafka, az Apache Flume, az Azure eseményközpontjai stb.

5. Patak feldolgozása

Kis eltérés van a valós idejű üzenetbevitel és az adatfolyam-feldolgozás között. Az előbbi figyelembe veszi a lenyelni kezdett adatokat, amelyeket először összegyűjtnek, majd közzétett előfizetési eszközként használnak. Az adatfeldolgozás ezzel szemben az összes, a Windowsban vagy a streamben előforduló adatfolyam kezelésére szolgál, majd az adatokat a kimeneti mosogatóba írja. Ide tartoznak az Apache Spark, az Apache Flink, a Storm stb.

6. Analytics alapú adattár

Ez az adattár, amelyet analitikai célokra használnak, ezért a már feldolgozott adatokat lekérdezik és elemzik olyan elemző eszközökkel, amelyek megfelelnek a BI megoldásoknak. Az adatok bemutathatók egy NoSQL adattárház-technológiával, például a HBase-vel, vagy a kaptár-adatbázis bármely interaktív felhasználásával, amely metaadat-kivonást biztosít az adattárban. Az eszközök közé tartozik a Hive, Spark SQL, Hbase stb.

7. Jelentés és elemzés

A betekintést a feldolgozott adatokból kell generálni, és ezt hatékonyan végzi a jelentési és elemzési eszközök, amelyek beágyazott technológiájukkal és megoldásukkal hasznos grafikonokat, elemzéseket és betekintést generálnak a vállalkozások számára. Az eszközök közé tartozik a Cognos, a Hyperion stb.

8. Zenekar

A nagy adat-alapú megoldások az adatokkal kapcsolatos műveletekből állnak, amelyek ismétlődő jellegűek, és be vannak ágyazva a munkafolyamatokba, amelyek átalakíthatják a forrásadatokat, áthelyezhetik az adatokat az egyes források között, valamint a mosogatókat és a raktárakat az üzletekben, és elemző egységekké alakíthatják. Ilyen például a Sqoop, az oozie, az adatgyár stb.

Következtetés

Ebben a bejegyzésben a nagy adat architektúráról olvashatunk, amely szükséges ahhoz, hogy ezeket a technológiákat a vállalatban vagy a szervezetben megvalósítsák. Remélem tetszett a cikkünk.

Ajánlott cikkek

Ez a Big Data Architecture útmutatója volt. Itt megvitatjuk, mi a nagy adat? meg is magyaráztuk a nagy adatok architektúráját és a blokkdiagramot. A további javasolt cikkeken keresztül további információkat is megtudhat -

- Big Data Technologies

- Big Data Analytics

- Karrier a nagy adatban

- Big Data interjú kérdései

- A tárgyak internetének 8 legfontosabb eszköze, amelyet tudnia kell

- Csatlakozás típusai a Spark SQL-ben (példák)