Bevezetés az adattudomány algoritmusaiba

Az adattudományban használt alapvető algoritmusok magas szintű leírása. Mint már tudod, az adattudomány egy olyan kutatási terület, ahol a döntéseket az adatokból nyert ismeretek alapján hozzák meg, a klasszikus szabályalapú determinisztikus megközelítések helyett. A gépi tanulási feladatokat általában három részre oszthatjuk

- Az adatok beszerzése és az üzleti probléma feltérképezése,

- Gépi tanulási technikák alkalmazása és a teljesítménymutatók megfigyelése

- A modell tesztelése és telepítése

Az egész életciklus során különféle adattudományi algoritmusokat használunk a feladat megoldására. Ebben a cikkben a leggyakrabban használt algoritmusokat osztjuk meg tanulási típusuk alapján, és ezekről magas szintű megbeszélést folytatunk.

Az adattudomány algoritmusai

A tanulási módszertanok alapján egyszerűen feloszthatjuk a gépi tanulás vagy az adattudomány algoritmusait a következő típusokra

- Felügyelt algoritmusok

- Nem felügyelt algoritmusok

1. Felügyelt algoritmusok

Ahogy a neve is sugallja, a felügyelt algoritmusok egy olyan gépi tanulási algoritmusok egy osztálya, ahol a modellt a megjelölt adatokkal képzik. Például a történeti adatok alapján meg akarja jósolni, hogy egy ügyfél nem teljesíti-e a kölcsönt. A címkézett adatok előfeldolgozása és tulajdonságainak megtervezése után a felügyelt algoritmusokat a strukturált adatok felett képzik és egy új adatponton tesztelik, vagy ebben az esetben a hitel-nemteljesítő előrejelzését. Merüljünk el a legnépszerűbb felügyelt gépi tanulási algoritmusokba.

- K Legközelebbi szomszédok

A K legközelebbi szomszédok (KNN) az egyik legegyszerűbb, de mégis hatékony gépi tanulási algoritmus. Ez egy felügyelt algoritmus, ahol a besorolást k legközelebbi adatpont alapján végzik el. A KNN gondolata az, hogy hasonló pontok csoportosulnak egymással, és a legközelebbi adatpontok tulajdonságainak mérésével osztályozhatunk egy teszt adatpontot. Például egy olyan általános osztályozási problémát oldunk meg, ahol azt akarjuk megjósolni, hogy egy adatpont az A osztályba vagy a B osztályba tartozik. Tegyük fel k = 3, most teszteljük a teszt adatpont 3 legközelebbi adatpontját, ha közülük kettő tartozik az osztályhoz Az A teszteredmény pontját A osztálynak nyilvánítja, egyébként B osztály. A K értékét keresztellenőrzéssel határozzuk meg. Lineáris időbonyolultsággal rendelkezik, ezért nem használható alacsony késleltetésű alkalmazásokhoz.

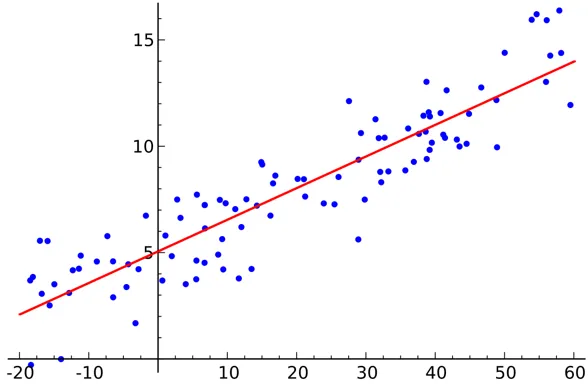

- Lineáris regresszió

A lineáris regresszió egy felügyelt adattudományi algoritmus.

Kimenet:

A változó folyamatos. Az ötlet az, hogy találjunk egy hiper síkot, ahol a maximális pontszám a hiper síkban fekszik. Például az eső mennyiségének előrejelzése egy standard regressziós probléma, ahol a lineáris regresszió felhasználható. A lineáris regresszió feltételezi, hogy a független és függő változók közötti kapcsolat lineáris, és a multikollinearitás nagyon kevés vagy egyáltalán nincs.

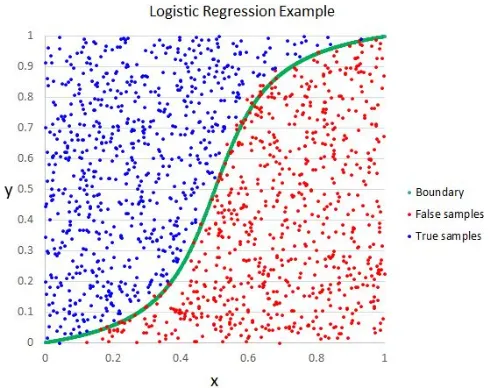

- Logisztikus regresszió

Noha a név regressziót mond, a logisztikus regresszió egy felügyelt osztályozási algoritmus.

Kimenet:

A geometriai intuíció az, hogy különféle osztálycímkéket választhatunk el egy lineáris döntési határ felhasználásával. A logisztikus regresszió kimeneti változója kategorikus. Felhívjuk figyelmét, hogy nem használhatjuk az átlagos négyzet hibát költségfüggvényként a logisztikai regresszióhoz, mivel nem konvex a logisztikai regresszióhoz.

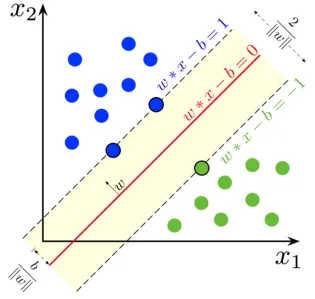

- Támogatja a vektorgépet

A logisztikus regresszió során fő mottónk egy elválasztó lineáris felület megtalálása volt.

Kimenet:

A támogatási vektorgépet ezen ötlet kiterjesztésének tekinthetjük, ahol meg kell találnunk egy hiper síkot, amely maximalizálja a marginot. De mi a tartalék ?. A W vektorhoz (a döntési felülethez, amelyet fel kell dolgoznunk) mindkét oldalán húzzunk két párhuzamos vonalat. A két vonal közötti távolságot marginnak nevezzük. Az SVM feltételezi, hogy az adatok lineárisan elválaszthatók. Noha az SVM-et nemlineáris adatokhoz is használhatjuk, a Kernel-trükköt is felhasználva.

- Döntési fa

A Döntési fa egy beágyazott If-Else alapú osztályozó, amely egy fához hasonló gráfszerkezetet használ a döntés meghozatalához. A döntési fák nagyon népszerűek és az egyik leggyakrabban alkalmazott felügyelt gépi tanulási algoritmus az egész tudomány területén. A legtöbb esetben összehasonlíthatóbb, mint a többi felügyelt algoritmus, jobb stabilitást és pontosságot biztosít, és robusztus a túlmutatók számára. A döntési fa kimeneti változója általában kategorikus, de felhasználható regressziós problémák megoldására is.

- együttesek

Az együttesek az adattudományi algoritmusok népszerű kategóriája, ahol több modellt használnak együtt a jobb teljesítmény érdekében. Ha ismeri a Kaggle-t (a Google által létrehozott platform az adattudományi kihívások gyakorlására és versenyzésére), akkor a legtöbb nyertes megoldás valamilyen együttes használata.

Durván feloszthatjuk az együtteseket a következő kategóriákba

- Zsákolás

- fellendítése

- Többrétegű

- Cascading

Véletlenszerű erdő, színátmenet-növelő döntési fák példák néhány népszerű együttes algoritmusra.

2. Nem felügyelt algoritmusok

Nem felügyelt algoritmusokat használnak azokhoz a feladatokhoz, ahol az adatokat nem címkézik. A nem felügyelt algoritmusok legnépszerűbb használata a klaszterezés. A csoportosítás a hasonló adatpontok kézi beavatkozás nélküli csoportosítása. Itt tárgyaljuk néhány népszerű, felügyelet nélküli gépi tanulási algoritmust

- K azt jelenti

A K Means egy véletlenszerű, felügyelet nélküli algoritmus, amelyet a klaszterezéshez használnak. A K Means az alábbi lépéseket követi

1.A K pontokat véletlenszerűen inicializálja (c1, c2..ck)

2. Az adatkészlet minden egyes pontjára (Xi)

Válassza ki a legközelebbi Ci (i = 1, 2, 3..k)

Adjuk hozzá Xi-t a Ci-hez

3. Számolja újra a centridot megfelelő mérőszámok (azaz a klaszter távolsága) használatával

4, Ismételje meg a (2) (3) lépést, amíg nem konvergál

- K ++

Az inicializálási lépés K értelemben tisztán véletlenszerű, és az inicializáláson alapulva a csoportosulás drasztikusan megváltozik. K azt jelenti, hogy a ++ megoldja ezt a problémát azáltal, hogy k valószínűségi módon inicializálja a tiszta véletlenszerűsítés helyett. K azt jelenti, hogy a ++ sokkal stabilabb, mint a klasszikus K.

- K Medoidok:

A K-medoidok szintén egy K-átlagon alapuló klaszterezési algoritmus. A kettő közötti fő különbség a K középérték középpontjai között nem feltétlenül létezik az adatkészletben, ez a helyzet a K medoidok esetében nem. A K medoidok jobban értelmezhetők a klaszterek számára. K eszköz minimalizálja a teljes négyzet hibát, míg K medoid minimalizálja a pontok közötti különbséget.

Következtetés

Ebben a cikkben az adattudomány területén használt legnépszerűbb gépi tanulási algoritmusokat tárgyaltuk. Mindezek után felmerül a kérdése, hogy „ melyik algoritmus a legjobb? - Nyilvánvaló, hogy itt nincs nyertes. Ez kizárólag a feladattól és az üzleti követelményektől függ. Mivel a bevált gyakorlat mindig a legegyszerűbb algoritmussal kezdődik, és fokozatosan növeli a komplexitást.

Ajánlott cikkek

Ez egy útmutató az adattudomány algoritmusaihoz. Itt megvitatjuk az adattudományi algoritmusok áttekintését és az adattudományi algoritmusok két típusát. Megnézheti az adott cikkeket is, hogy többet megtudjon-

- Adattudományi platform

- Adattudományi nyelvek

- Osztályozási algoritmusok

- Adatbányászati algoritmusok

- Az együttesek tanulásának leggyakrabban használt technikái

- A döntési fa létrehozásának egyszerű módjai

- Az adattudomány életciklusának teljes útmutatója