Bevezetés a besorolási algoritmusokba

A besorolási algoritmusokról szóló cikk áttekintést nyújt az adatbányászati technikákban általánosan alkalmazott különböző osztályozási módszerekről, különféle elvekkel. A besorolás egy olyan módszer, amely az adatokat kategorizálja külön osztályokba, és az egyes osztályokhoz címkét rendelnek. A besorolás fő célja az új adatok elindításához szükséges osztály azonosítása az edzéskészlet elemzésével, a megfelelő határok látásával. Általánosságban a célosztály előrejelzését és a fenti folyamatot osztályozásnak nevezzük.

Például a kórház vezetősége rögzíti a beteg nevét, címét, életkorát, korábbi kórtörténetét a diagnosztizálásukig, ez segít a betegek osztályozásában. Két szakaszra bonthatók: tanulási szakaszra és értékelési szakaszra. A tanulási szakasz modellezi a megközelítési alapot képzési adatokkal, míg az értékelési szakasz előrejelzi az adott adatok kimenetét. Alkalmazásaikat az e-mail spamben, a bankhitel-előrejelzésben, a beszédfelismerésben, a hangulat-elemzésben találtuk meg. A technika magában foglalja az f matematikai függvényt X bemenettel és Y kimenettel.

Magyarázza el részletesen a besorolási algoritmusokat

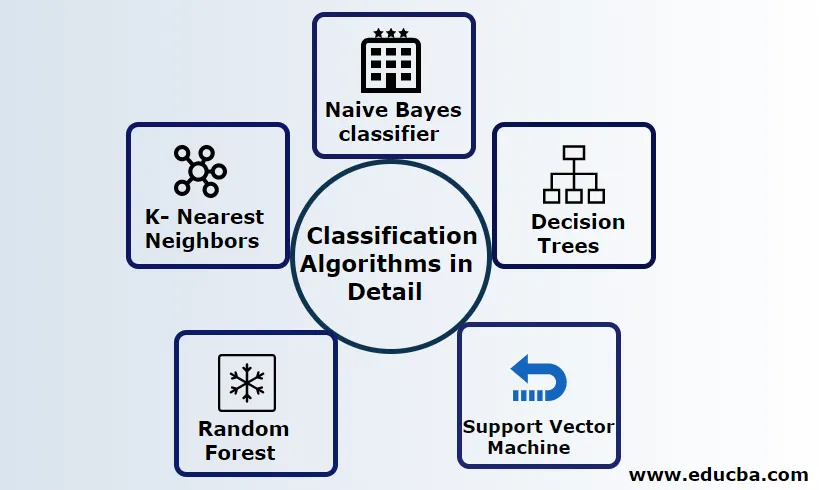

Az osztályozás strukturált és strukturálatlan adatokra is elvégezhető. Az osztályozás kategóriákba sorolható

- Naiv Bayes osztályozó

- Döntési fák

- Támogatja a vektorgépet

- Véletlenszerű erdő

- K- Legközelebbi szomszédok

1) Naiv Bayes osztályozó

Ez egy Bayes-féle tétel alapú algoritmus, az egyik statisztikai osztályozás, és kevés mennyiségű képzési adatot igényel a paraméterek, más néven valószínűségi osztályozók néven történő becsléséhez. A leggyorsabb osztályozónak tekintik, erősen skálázható és diszkrét és folyamatos adatokat kezel. Ez az algoritmus előrejelzést készített valós időben. Különböző típusú naiv osztályozók léteznek: Multinomial Naiv Bayes, Bernoulli Naiv Bayes, Gauss naiv.

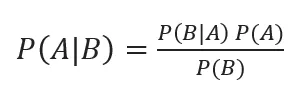

A Bayes-féle osztályozást a hátsó valószínűségekkel a

Ahol A, B események, P (A | B) - hátsó valószínűségek.

Ha két érték egymástól független, akkor

P (A, B) = P (A) P (B)

A naiv Bayes építhető a python könyvtár segítségével. A naiv prediktorok függetlenek, bár ajánlási rendszerekben használják őket. Számos valós idejű alkalmazásban használják, és tudatosan használják a dokumentumok osztályozásában.

Előnyök:

Előnyök, ha nagyon kevesebb számítási teljesítményt igényelnek, feltételezve a több osztályba sorolt előrejelzési problémákat, és pontosan működnek nagy adatkészleteknél.

Hátrány:

Ennek az osztályozónak a fő hátránya, hogy nulla valószínűséget fognak kiosztani. És vannak olyan tulajdonságaik, amelyekkel függetlenek egymástól.

2) Döntési fa

Ez egy felülről lefelé mutató megközelítési modell, amelynek folyamatábrája a nagydimenziós adatokat kezeli. Az eredményeket az adott bemeneti változó alapján becsüljük meg. A következő elemekből álló döntési fa: Gyökér, sok csomópont, ág, levél. A gyökércsomópont a partíciót az osztály attribútumértéke alapján hajtja végre, a belső csomópont egy attribútumot vesz fel a további osztályozáshoz, az ágak döntési szabályt hoznak a csomópontok levélcsomópontokra történő felosztására, végül a levélcsomók adják a végső eredményt. A döntési fa időbeli összetettsége a rekordok számától, a képzési adatok jellemzőitől függ. Ha a döntési fa túl hosszú, nehéz elérni a kívánt eredményt.

Előny: A prediktív elemzéshez alkalmazzák a problémák megoldására, és a napi tevékenységek során használják a cél kiválasztására a döntési elemzés alapján. A forrásadatok alapján automatikusan épít egy modellt. A legjobb a hiányzó értékek kezelésében.

Hátrány: A fa mérete ellenőrizhetetlen, amíg nincs bizonyos megállási kritériuma. Hierarchikus szerkezetük miatt a fa instabil.

3) A Vector Machine támogatása

Ez az algoritmus létfontosságú szerepet játszik az osztályozási problémákban, és a legnépszerűbb a gépi tanulás által felügyelt algoritmusok. Ez egy fontos eszköz, amelyet a kutató és az adattudós használ. Ez az SVM nagyon egyszerű, folyamata egy hiper sík megtalálása egy N-dimenziós térbeli adatpontokban. A hiper sík döntési határok, amelyek osztályozzák az adatpontokat. Mindez a vektor közelebb esik a hipersíkhoz, maximalizálva az osztályozó margóját. Ha a margó maximális, akkor a legalacsonyabb az általánosítási hiba. Végrehajtásuk a kerneltel python használatával végezhető el, néhány képzési adatkészlettel. Az SVM fő célja egy objektum egy adott osztályozásba történő kiképzése. Az SVM nem korlátozódik arra, hogy lineáris osztályozóvá váljon. Az SVM-et jobban részesítik előnyben, mint bármely más osztályozási modellt a kernel funkciójuk miatt, amely javítja a számítási hatékonyságot.

Előny: Nagyon előnyösek a kevesebb számítási teljesítmény és a hatékony pontosság miatt. Hatékony nagyméretű térben, jó memóriahatékonyság.

Hátrány: A sebesség, a kernel és a méret korlátozása

4) Véletlenszerű erdő

Ez egy hatalmas gépi tanulási algoritmus, amely az Ensemble tanulási megközelítésén alapszik. A Random forest alapvető építőeleme a prediktív modellek felépítéséhez használt döntési fa. A munkabemutatás magában foglalja egy véletlenszerű döntésű fák erdőjének létrehozását, és a metszés folyamatát egy jobboldali eredmény elérése érdekében megállító hasítás beállításával hajtják végre. A véletlenszerű erdőt a csomagolásnak nevezett technikával valósítják meg a döntéshozatalhoz. Ez a zsákolás megakadályozza az adatok túlzott illeszkedését azáltal, hogy csökkenti az torzítást, hasonlóan ez a véletlenszerűség jobb pontosságot eredményezhet. A végső előrejelzést sok döntési fa átlaga veszi át, azaz a gyakori előrejelzések. A véletlenszerű erdő számos felhasználási esetet foglal magában, például tőzsdei előrejelzéseket, csalások felderítését, hírek előrejelzéseit.

Előnyök:

- Nem igényel nagy adatfeldolgozást az adatkészletek feldolgozásához, és nagyon egyszerű modellt kell készíteni. Nagyobb pontosságot nyújt a prediktív problémák megoldásában.

- Jól működik a hiányzó értékek kezelésében, és automatikusan felismeri a külső értékeket.

Hátrány:

- Nagy számítási költségeket és nagy memóriát igényel.

- Sokkal több időt igényel.

5) K- Legközelebbi szomszédok

Itt a K-NN algoritmust tárgyaljuk a CART felügyelt tanulásával. Használják a K pozitív kis egész számot; egy objektumot az osztályhoz rendelnek a szomszédok alapján, vagy azt mondjuk, hogy egy csoportot rendelünk hozzá, megfigyelve, hogy melyik csoportban fekszik a szomszéd. Ezt az Euklide-i távolság és a nyers erő határozza meg. K értéke megtalálható a hangolási folyamat segítségével. A KNN nem szívesen tanul semmilyen modellt új adatkészlet kiképzéséhez és az normalizáláshoz az adatok átméretezéséhez.

Előny: Hatékony eredményeket hoz, ha hatalmas a képzési adatok.

Hátrány: A legnagyobb probléma az, hogy ha a változó kicsi, akkor jól működik. Másodszor, a K tényező kiválasztása a besorolás során.

Következtetés

Összegezve, megvizsgáltuk a különféle osztályozási algoritmusok képességeit, amelyek továbbra is hatékony eszközként szolgálnak a szolgáltatástervezésben, a kép osztályozásban, amely nagyszerű forrást jelent a gépi tanuláshoz. A besorolási algoritmusok hatékony algoritmusok, amelyek megoldják a nehéz problémákat.

Ajánlott cikkek

Ez egy útmutató a gépi tanulás osztályozási algoritmusaihoz. Itt megvitatjuk, hogy az osztályozás strukturált és strukturálatlan adatokra is végrehajtható. Megnézheti más javasolt cikkeinket -

- Útválasztási algoritmusok

- Klaszterezési algoritmus

- Adatbányászati folyamat

- Gépi tanulási algoritmusok

- Az együttesek tanulásának leggyakrabban használt technikái

- C ++ algoritmus | Példák a C ++ algoritmusra