Mi a Kafka?

A Kafka megértéséhez jobb megérteni, hogy mi az „adatfeldolgozás” technológia. „Az adatfeldolgozás olyan technológia, amelynek segítségével a felhasználó folyamatos adatfolyamra kérdezhet mikro időkeretet, hogy jobban megértse a felelős mögöttes feltételeket.

Valósidejű forgatókönyv - képzelje el, ha a hőmérséklet-érzékelő olyan adatokat küld, amelyekre lekérdezhet és riasztást kaphat a fagypont elérése után. Ez az adatkérdezés mikrosekundumokban elvégezhető.

Definíciók

Wiki szerint nyílt forrású adatfeldolgozó szoftver. A LinkedIn fejlesztette ki, majd később az Apache szoftvernek adományozta.

A Kafka megértése

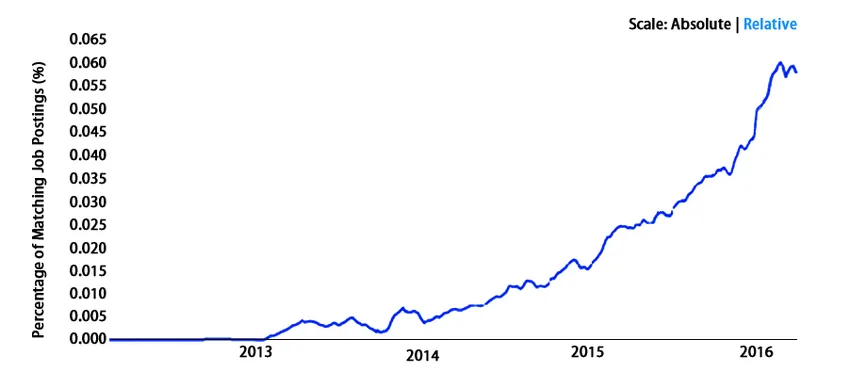

Növekedése exponenciálisan felrobban. Lássuk néhány tényt és statisztikát, hogy jobban aláhúzzuk gondolatainkat. A világ minden tájáról a Fortune 500 több mint egyharmadát élvezi elsődlegesen. Ezt az eloszlást megosztják az utazási irodák, a távközlési óriások, a bankok és még sokan mások. A LinkedIn, a Microsoft és a Netflix naponta négy vesszővel ellátott üzeneteket dolgoz fel a Kafkával (csaknem egyenlő 1 000 000 000 000).

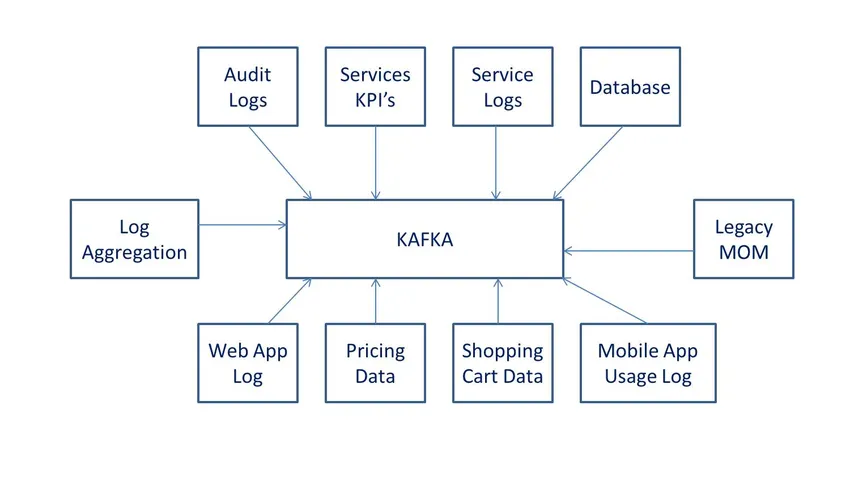

Valós idejű adatfolyamokra, nagy adatgyűjtésre vagy valósidejű elemzésre (vagy mindkettőre) használják. A Kafkát a memóriában található mikroszolgáltatásokkal használják a tartósság biztosítása érdekében, és felhasználható események továbbítására a CEP (komplex esemény streaming rendszerek) és az IoT / IFTTT stílusú automatizálási rendszerekbe.

Hogyan működik olyan egyszerű a Kafka?

Az egyszerűség vezérlése lenne a megfelelő módszer a teljesítmény meghatározására. Könnyű kitalálni, hogyan működik ilyen egyszerűen a Kafka a felépítésétől és a használatától kezdve. A viselkedés fokozott teljesítményét a stabilitásnak, a megbízható tartósságnak és a beépített rugalmas képességnek köszönheti, amely képes karbantartást közzétenni, feliratkozni vagy sorba állítani. Ez nagyon fontos, ha N-számú ügyfélcsoporttal kell foglalkozni, ha erőteljes replikációt kell mutatnia a piacon, amelynek célja az ügyfelek számára következetes megközelítés (azaz a Kafka témapartíciója). A Kafka egyik alapvető viselkedése, amely megkülönbözteti a versenytársaitól, az, hogy kompatibilis az adatfolyamokkal rendelkező rendszerekkel - a folyamat és lehetővé teszi ezeknek a rendszereknek a más üzletek összesítéséhez, átalakításához és betöltéséhez a kényelmes munkavégzést. „Az összes fent említett tény nem lenne lehetséges, ha Kafka lassú lenne”. Kivételes teljesítménye ezt lehetővé teszi.

A Kafka könnyebb működése mellett az „OS szintre” kell lépnünk. Nézzük meg, hogyan működnek a dolgok a Kafka számára operációs rendszer szinten -

- Az operációs rendszermagokra támaszkodik az adatok gyorsabb mozgatására, és a nulla másolás elvén működik.

- Ez lehetővé teszi az adatrekordok darabonkénti szakaszolását, amely a fájlrendszerből (más néven Kafka témanapló) látható a fogyasztók számára.

- Az adatok kötegelt képessége hatékony adattömörítést biztosít az I / O késleltetés csökkentésével.

- Képes vízszintesen skálázni a szilánkok segítségével. Ez a címeket naplózhatja több száz partícióba, több ezerre. Ez lehetővé teszi a hatalmas munkaterhelés könnyű kezelését.

Mit lehet tenni Kafkával?

Ha cége rendszeresen hatalmas adathalmazokkal játszik, akkor szüksége van Kafkára. Hosszú listája van a cégeket használó vállalkozásoknak.

- A LinkedIn az adatok és az operatív mutatók nyomon követésére szolgál.

- A Twitter adatfolyam-feldolgozási infrastruktúrákat biztosít.

Hosszú lista van az Ubertől a Spotify-ig és a Goldman Sachs-tól a Ciscoig.

Előnyök

- Nagy teljesítmény: Nagy sebességgel generálhat nagy mennyiségű adatot, kivételes előny a Kafka számára. Ennek az alkalmazásnak nincs hatalmas hardvere. Annak a képességének köszönhetően, hogy másodpercenként ezer üzenet frekvenciáján támogatja az üzenetek átvitelét.

- Alacsony késleltetés: Alacsony késleltetés a nagy mennyiségű üzenet generálása során.

- Hibatűrés: Ez a szolgáltatás nagyon hasznos, jellegzetes képességét korlátozza egy klaszterbe beépített csomópont.

- Tartós: működése nagyon tartós, ezért sok MNC inkább a Kafkát használja. A műveletek tartósságáról beszélve az üzenetek hosszú távon nem veszhetnek el.

Szükséges készségek

A Kafka szakembereinek nincs külön követelménye. De aláhúztunk néhány irányt és szakembert -

- Azok a fejlesztők, akik szívesen akarnak karriert keresni a Big Data streamben, és fel akarják gyorsítani a karriert.

- A tesztelő szakembereknek jó hatókörük van Kafkában a sorbaállítási és üzenetküldési rendszerek szempontjából

- Építészek - mivel mindennek szüksége van bizonyos keretre, és ez a keret időről időre frissíthető. A Big Data építészek Kafkát jó karrierbefektetésnek találják.

- Projektmenedzserre van szükség, ha a fenti szakember van az erőforrások jobb kezelése érdekében. Tehát magasabb beosztás áll a Kafka területén a vezetési szakemberek rendelkezésére.

Miért érdemes használni a Kafkát?

Az adatkövetés és az üzleti igényeknek megfelelő manipuláció céljából a Kafkát világszerte előnyben részesítik. Lehetővé teszi az adatok valós időben történő adatfolyamát valós idejű elemzéssel. Gyors, skálázható és tartós, és hibatűrővé vált. Számos felhasználási eset van jelen az interneten keresztül, ahol láthatja, hogy miért nem gondolják a JMS, a RabbitMQ és az AMQP működését együtt, mivel hatalmas mennyiségű és reagáló képességre van szükség.

Nagy áteresztőképességű, megbízható beállítással és replikációs jellemzőkkel rendelkezik, ezért az IoT érzékelőkkel történő munkavégzés kedvezőbb.

A kompatibilitás a használat további oka, és világszerte elfogadhatóvá tette. Könnyen konfigurálható az alább felsorolt alkalmazásokkal való együttműködésre. Ez a kombináció nagyon fontos a sok vállalkozás számára az üzleti növekedés és a túlélés szempontjából (mivel időt és pénzt takarít meg).

- Flume

- Spark streaming

- HBase

- Szikra az adatok valós idejű beviteléhez, feldolgozásához és elemzéséhez.

- Ez a szokás a Hadoop BigData táplálására

terület

Nagyon jól teljesít az egész világon. Nos, ezt nem inkább a statisztikákról mondjuk. Nézzük meg -

Fizetési statisztikák a Kafka szakemberek számára - PayScale

- Szoftvermérnök - 109 825 USD

- Adatmérnök - 109 580 USD

- Fejlesztők - 81 182 USD

- Senior Data Engineer - 127 836 USD

Következtetés

Jelenleg a Kafka de facto szabványvá vált, amikor a valós idejű adatelemzéshez mikrosekundumban a legnagyobb pontossággal kerül sor. Bemutattuk betekintésünket adatokkal és részletekkel kapcsolatban a Kafka technológiák támogatására. Számos nagyvállalat napi rendszerességgel használja ki az adatokat, és ehhez szakemberekre van szükségük e hatalmas adatkészletek kiaknázásához. A Kafkával biztos lehet benne, hogy karrierjét a BigData elemzés területén vezetik

Ajánlott cikkek

Ez egy útmutató a Mi a Kafka számára. Itt megvitattuk a Kafka működését, alkalmazási körét, karrier-növekedését és előnyeit. A további javasolt cikkeken keresztül további információkat is megtudhat -

- Mi az Apache?

- Mi a nagy adat és a Hadoop?

- Mi az Azure?

- Mi a Big Data Technology?

- Kafka vs Spark | 5 legfontosabb különbség

- A Kafka áttekintése és legfontosabb alkalmazásai

- Kafka vs Kinesis 5 különbség az infographics-hoz képest