Mi az NLP a Pythonban?

A mesterséges intelligencia rendkívüli mértékben fejlődött az elmúlt évtizedben, és ezért az egyik alterülete - a természetes nyelv feldolgozása. Az AI fejlődése a modern rendszerek hatalmas számítási kapacitása, valamint a nagy mennyiségű strukturálatlan adat eredménye, mely sok forrásból származik. A természetes nyelv feldolgozása vagy az NLP az AI tanulmányozása, amely lehetővé teszi a számítógépek számára a nyers, strukturálatlan szöveges adatok feldolgozását és rejtett betekintések kinyerését.

Meghatározás

Az emberekkel ellentétben a számítógépek nem elég intelligensek a strukturálatlan adatok feldolgozásához. Az emberi lények az ilyen adatokból származtathatók, míg a számítógépek ezt csak az adatbázisokban tárolt strukturált adatokkal tudják megtenni. A minták megkereséséhez és a természetes adatok értelmezéséhez a számítógépek az NLP-ben részt vevő eszközöket és technikákat használják az ilyen adatok feldolgozására.

Hogyan működik az NLP a Pythonban?

Nagyon bonyolult az angol nyelv olvasása és megértése. Az alábbi mondat egy ilyen példa, ahol a számítógép számára nagyon nehéz megérteni a mondat mögött rejlő gondolatot.

A gépi tanulás során egy csővezetéket építenek minden problémára, ahol a probléma minden egyes elemét külön-külön oldják meg az ML segítségével. A végeredmény több, egymással láncolt gépi tanulási modell kombinációja lenne. A természetes nyelvfeldolgozás ehhez hasonlóan működik, ha az angol mondat darabokra van felosztva.

Ebben a bekezdésben számos tény található. Könnyű lett volna, ha a számítógépek maguk is megértenék, mi is London, de ehhez a számítógépeket írásbeli nyelvi alapkoncepciókkal kell képezni.

1. Mondat szegmentáció - A korpusz több mondatra oszlik, mint az alábbiakban.

Ez megkönnyítené az életünket, mivel jobb egyetlen mondat feldolgozása, mint egy bekezdés egésze. A felosztás elvégezhető írásjelek vagy több más bonyolult módszer alapján, amely a tisztítatlan adatokra is működik.

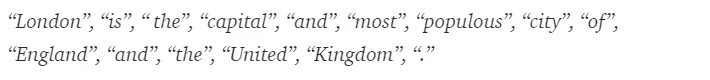

2. Szó tokenizálása - Egy mondat tovább bontható szavak tokenjévé, az alább látható módon.

A tokenizálás után a fenti mondat fel van osztva -

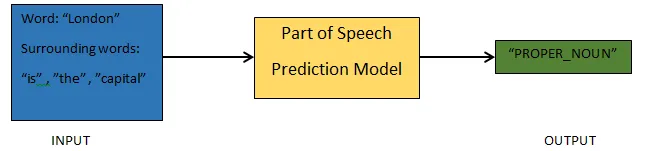

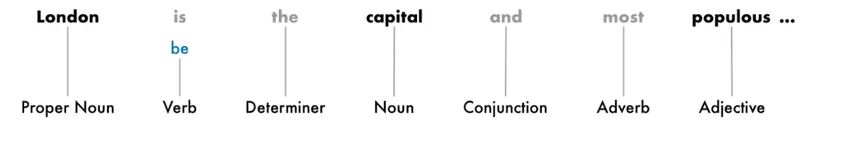

3. A beszéd előrejelzésének részei - Ez a folyamat a beszéd részeinek előállítását jelenti minden egyes token számára. Ez lehetővé tenné számunkra, hogy megértsük a mondat jelentését és a mondatban tárgyalt témát.

4. Lemmatizálás - A mondatban szereplő szavak különböző formákban jelenhetnek meg. A lemmatizálás egy szót visszavezet a gyökérzetéhez, azaz az egyes szavak lemmájához.

5. Állítsa le a szavak azonosítását - A mondatban nagyon sok töltőszó található, mint például az „a”, „a”. Ezek a szavak úgy viselkednek, mint a zaj egy szövegben, amelynek jelentését megpróbáljuk kimeríteni. Ezért a jobb modell felépítése érdekében ki kell szűrni ezeket a stop szavakat.

Az alkalmazás alapján a stop szavak változhatnak. Létezik azonban egy előre definiált stop munkák listája, amelyekre hivatkozhat.

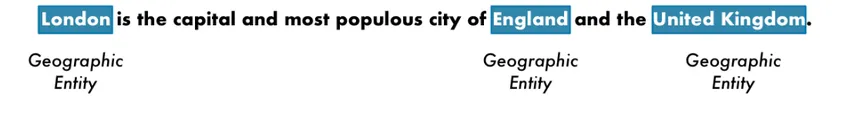

6. Elnevezett entitásfelismerés - A NER az az entitás, például név, hely, személy, szervezet stb., Egy mondatból.

A szó egy mondatban való megjelenésének összefüggéseit itt használjuk. A strukturált adatok szövegből való kikerüléséhez a NER rendszereknek sok felhasználásuk van.

Példa az NLP-re Pythonban

A legtöbb vállalat most hajlandó strukturálatlan adatokat feldolgozni üzleti növekedéséhez. Az NLP széles körű felhasználással rendelkezik, és a leggyakoribb esetek a szöveges osztályozás.

A szöveg automatikus különféle kategóriákba történő besorolását szöveges osztályozásnak nevezzük. A spam vagy a ham észlelése egy e-mailben, a hírcikkek osztályozása a szöveges osztályozás leggyakoribb példái. Az erre a célra felhasznált adatokat meg kell jelölni.

A szöveg-osztályozási folyamatban követendő néhány lépés, amelyet be kell tartani:

- Az első lépés az adatok betöltése és előfeldolgozása, majd az oszlopokra osztható és validálási halmazra osztható.

- A Feature Engineering lépés magában foglalja a hasznos szolgáltatások kibontását vagy további értelmes szolgáltatások létrehozását, amelyek elősegítik a jobb prediktív modell kidolgozását.

- A modell felépítéséhez a címkézett adatkészletet kell használni a modell kiképzéséhez.

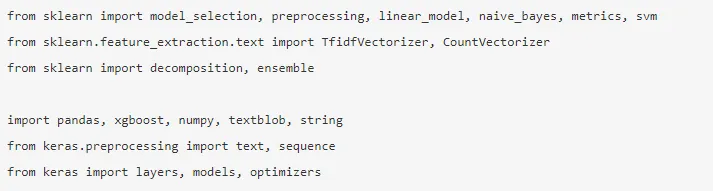

A Pandák, a Scikit-learning, az XGBoost, a TextBlog, a Keras kevés olyan könyvtárból, amelyet telepíteni kell. Akkor importálnánk a könyvtárakat az adatkészlet előkészítéséhez, a szolgáltatás tervezéséhez stb.

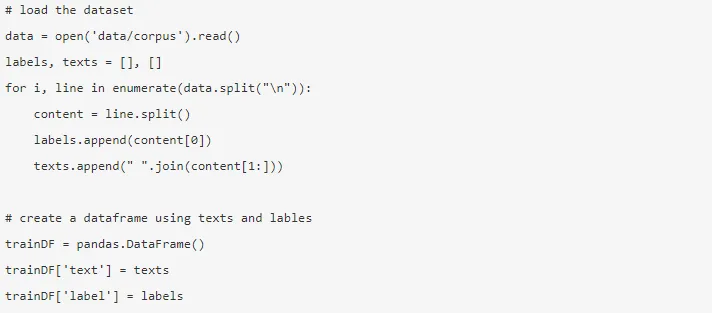

Az adatok hatalmasak, és majdnem 3, 6 millió véleményt lehet letölteni innen. Az adatok töredékét használjuk. Töltse le és olvassa be a Panda adatkeretbe.

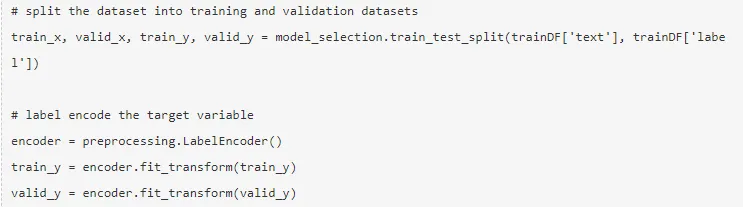

A célváltozót kódolják, és az adatokat felosztják vonatra és tesztkészletre.

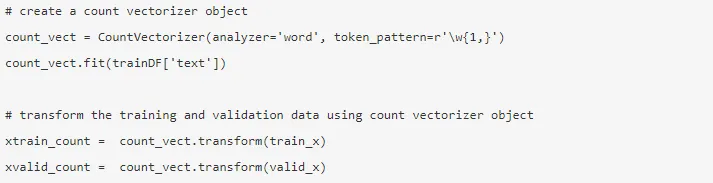

A szolgáltatás fejlesztését az alábbiakban bemutatott különböző módszerekkel hajtják végre.

1. Grófvektorok - A dokumentum, a kifejezés és annak korpuszból való frekvenciáját a gráfvektorok képezik.

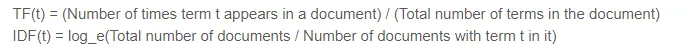

2. TF-IDF vektorok - Egy dokumentumban egy kifejezés relatív fontosságát a term frekvencia (TF) és a fordított dokumentum frekvencia (IDF) pontszám jelöli. A TF-IDF kiszámítható:

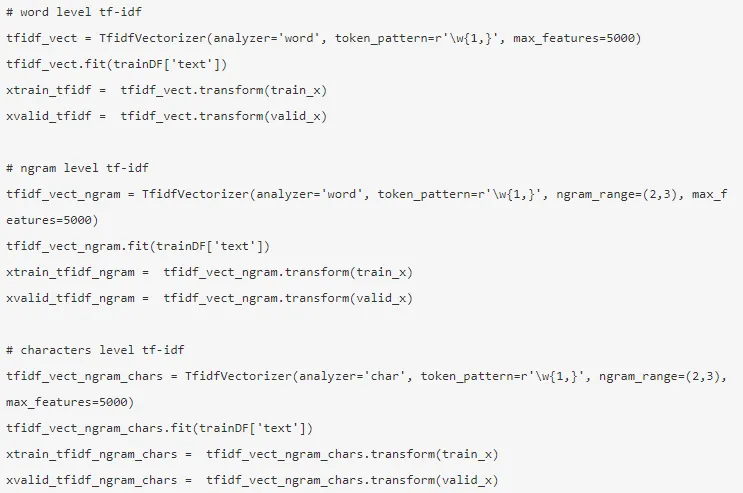

A TF-IDF vektorokat Word-szinttel lehet létrehozni, amely bemutatja az egyes kifejezések pontszámát, és az N-gram szinttel, amely az n-kifejezések kombinációja.

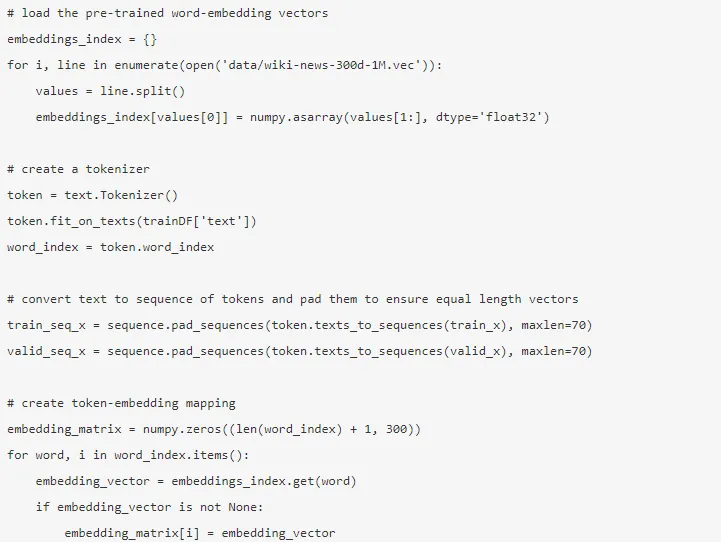

3. Szó beágyazása - A dokumentumok és a szavak sűrű vektor formájában történő ábrázolását szóba ágyazásnak nevezzük. Vannak előre képzett beágyazások, mint például a kesztyű, a Word2Vec, amelyek felhasználhatók vagy kiképzhetők is.

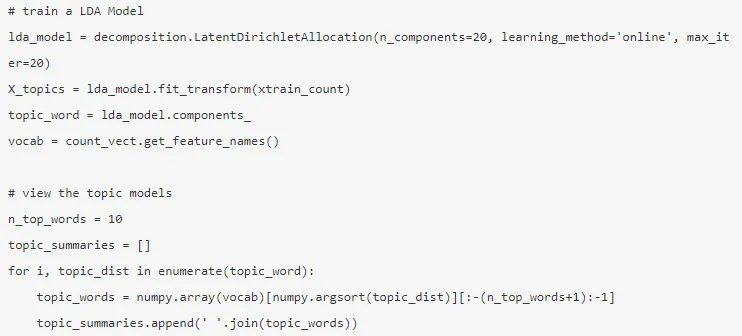

4. Téma-modellek - A dokumentum szavakból álló csoportja szállítja a legtöbb információt. A látens Dirichlet-kiosztást itt használják a téma modellezéséhez.

Az üzemmódot a szolgáltatás tervezésének befejezése és az ehhez szükséges szolgáltatások kibontása után építik fel.

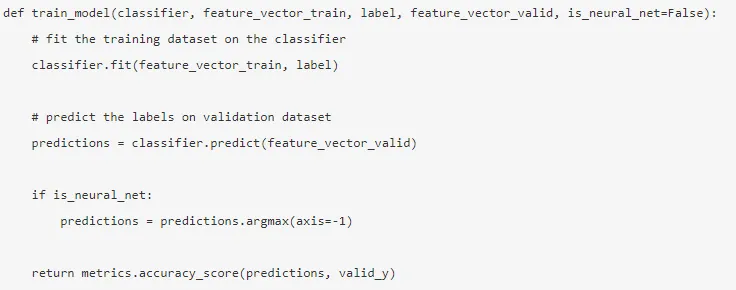

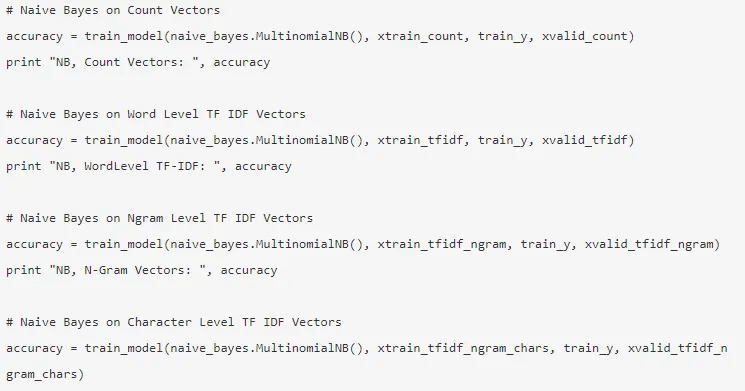

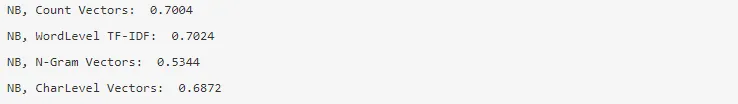

5. Naiv Bayes - a Bayes tételre épül, és az algoritmus úgy véli, hogy az adatkészlet jellemzői között nincs kapcsolat.

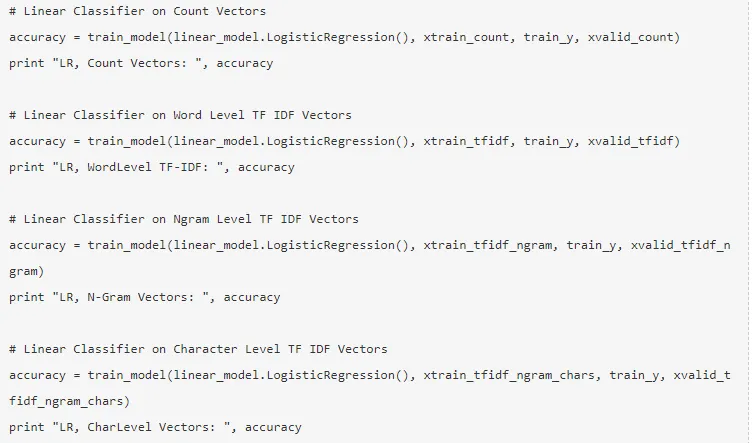

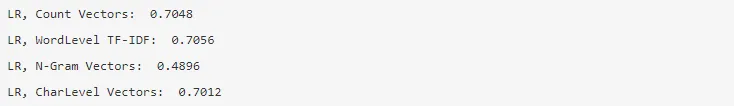

6. Logisztikus regresszió - a jellemzők közötti lineáris kapcsolatot méri, és a célváltozót a valószínűségeket becslő szigmoid függvény alapján mérik.

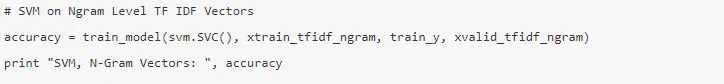

7. Támogatja a vektorgépet - A hiper sík két osztályt választ el az SVM-ben.

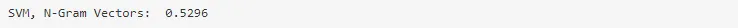

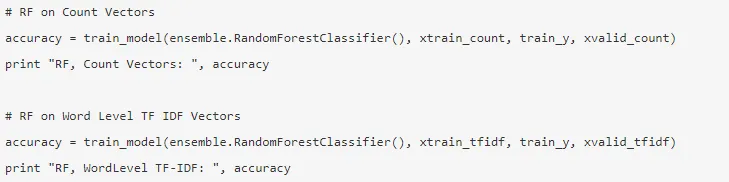

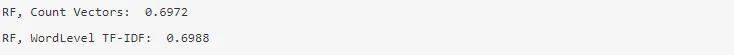

8. Véletlenszerű erdő modell - Olyan együttes modell, amely csökkenti a varianciát, és több döntési fát összerak.

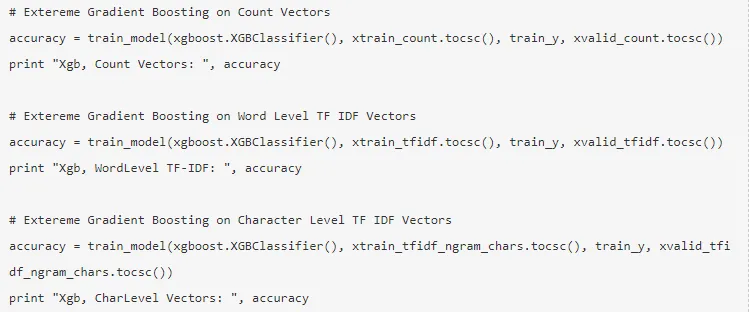

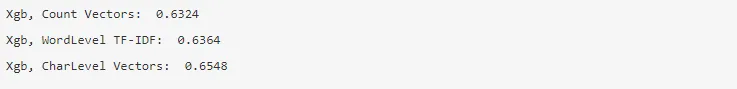

9. XG Boost - Az elfogultság csökkent, és a gyenge tanulók erőské válnak.

Hogyan segítheti az NLP a karrierjét?

A természetes nyelv feldolgozása virágzó terület a piacon, és szinte minden szervezetnek szüksége van egy NLP mérnökre a nyers adatok feldolgozásához. Ezért elengedhetetlen a szükséges készségek elsajátítása, mivel a piacon nem lesz munkahely.

Következtetés: NLP Pythonban

Ebben a cikkben az NLP bevezetésével kezdtük el a Python-ban, majd Python-ban bevezettünk egy használati esetet annak bemutatására, hogyan kell az NLP-vel együtt dolgozni Pythonban.

Ajánlott cikkek

Ez egy útmutató az NLP-hez Pythonban. Itt megvitassuk a példát, az esetek használatát és az NLP-vel való együttműködést a Pythonban. A további javasolt cikkeken keresztül további információkat is megtudhat -

- A Python felhasználásai

- Mi a WBS?

- Python vs Scala

- Mi az a Tableau?