Bevezetés a kernel módszerekbe

A kernelek vagy a kernel módszerek (más néven Kernel függvények) különféle típusú algoritmusok halmaza, amelyeket a minta elemzésére használnak. Egy nemlineáris probléma megoldására használják őket egy lineáris osztályozó segítségével. A kernelek módszereit az SVM (Support Vector Machines) alkalmazza, amelyeket osztályozási és regressziós problémákhoz használnak. Az SVM az úgynevezett „Kernel Trick” -nek felel meg, ahol az adatok átalakulnak és optimális határ található a lehetséges kimenetek számára.

A kernel módszer szükségessége és működése

Mielőtt belekezdenénk a Kernel Methods működésébe, fontosabb megérteni a támogató vektor gépeket vagy az SVM-eket, mivel a kernelek SVM modellekben vannak megvalósítva. Tehát a Support Vector Machines olyan felügyelt gépi tanulási algoritmusok, amelyeket osztályozási és regressziós problémákhoz használnak, például egy alma osztályozása a gyümölcs osztályához, míg az oroszlán osztályozása az osztály állatához.

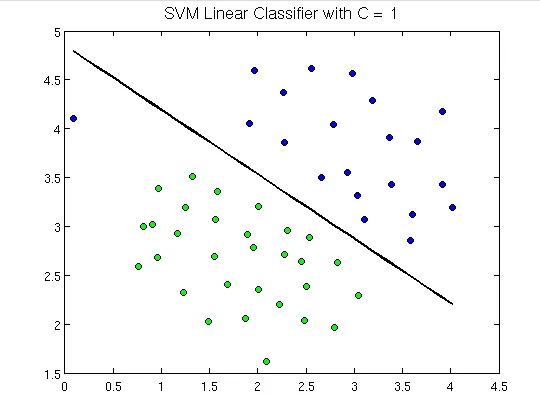

Az alábbiakban bemutatjuk, hogy néznek ki a támogató vektorgépek:

Itt láthatunk egy hiper síkot, amely elválasztja a zöld pontokat a kékktől. A hipersík egy dimenzióval kevesebb, mint a környezeti sík. Például a fenti ábrán 2 dimenziónk van, amely a környező teret ábrázolja, de az a magány, amely osztja vagy osztályozza a teret, egy dimenzióval kevesebb, mint a környezeti tér, és hiper síknak nevezzük.

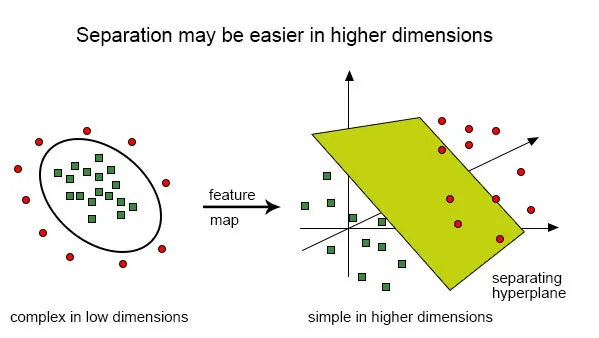

De mi van, ha van ilyen információ:

Nagyon nehéz ezt a besorolást egy lineáris osztályozóval megoldani, mivel nincs jó olyan lineáris vonal, amely képes lenne a vörös és a zöld pontok besorolására, mivel a pontok véletlenszerűen vannak elosztva. Itt jön a rendszermag funkció használata, amely a pontokat magasabb dimenziókba helyezi, ott megoldja a problémát, és visszatér a kimenethez. Ilyen módon gondolkodva láthatjuk, hogy a zöld pontok be vannak zárva valamilyen kerületi területre, míg a vörös kívül helyezkedik el, és lehetnek olyan forgatókönyvek is, ahol a zöld pontok eloszlanak egy trapéz alakú területen.

Tehát azt a kétdimenziós síkot konvertáljuk, amelyet először egydimenziós hiper sík („vagy egyenes vonal”) osztályozott háromdimenziós területre, és itt az osztályozónk, azaz a hipersík nem egyenes lesz, hanem egy kettő -dimenziós sík, amely levágja a területet.

A kernel matematikai megértése érdekében értsük meg a Lili Jiang kernel egyenletét, amely a következő:

K (x, y) = ahol,

K a kernel függvény,

X és Y a dimenziós bemenetek,

f az n-dimenziós térből az m-dimenziós tér térképe, és

a ponttermék.

Illusztráció egy példa segítségével.

Tegyük fel, hogy két pontunk van, x = (2, 3, 4) és y = (3, 4, 5)

Mint láttuk, K (x, y) =.

Először számítsuk ki

f (x) = (x1x1, x1x2, x1x3, x2x1, x2x2, x2x3, x3x1, x3x2, x3x3)

f (y) = (y1y1, y1y2, y1y3, y2y1, y2y2, y2y3, y3y1, y3y2, y3y3)

így,

f (2, 3, 4) = (4, 6, 8, 6, 9, 12, 8, 12, 16) és

f (3, 4, 5) = (9, 12, 15, 12, 16, 20, 15, 20, 25)

tehát a ponttermék,

f (x). f (y) = f (2, 3, 4). f (3, 4, 5) =

(36 + 72 + 120 + 72 +144 + 240 + 120 + 240 + 400) =

1444

És,

K (x, y) = (2 * 3 + 3 * 4 + 4 * 5) 2 = (6 + 12 + 20) 2 = 38 * 38 = 1444.

Ez, amint megtudtuk, f (x) .f (y) és K (x, y) ugyanazt az eredményt adja, de az előbbi módszer sok számítást igényelt (mivel a három dimenziót 9 dimenzióba vetítettük), miközben a kernel, sokkal könnyebb volt.

A kernel típusai és módszerei az SVM-ben

Nézzük meg az SVM-ben használt kernelfüggvényeket vagy típusokat:

1. Liner kernel - Tegyük fel, hogy két vektorunk van x1 és Y1 névvel, akkor a lineáris kernelt ezen két vektor pont szorzata határozza meg:

K (x1, x2) = x1. x2

2. Polinomiális kernel - A polinomiális kernelt a következő egyenlet határozza meg:

K (x1, x2) = (x1, x2 + 1) d,

Hol,

d a polinom foka, x1 és x2 vektorok

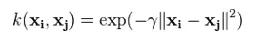

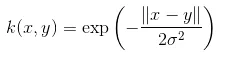

3. Gauss-kernel - Ez a kernel egy sugárirányú alapfunkciós kernel példája. Az alábbiakban látható az egyenlet ehhez:

Az adott szigma nagyon fontos szerepet játszik a Gauss-kernel teljesítményében, és nem szabad túlbecsülni és alábecsülni, azt gondosan be kell hangolni a probléma függvényében.

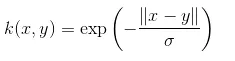

4. Exponenciális kernel - Ez szoros kapcsolatban van az előző kerneltel, azaz a Gauss-kerneltel, amelynek egyetlen különbsége az, hogy - a normál négyzetét eltávolítják.

Az exponenciális függvény funkciója:

Ez egy radiális alapú kernelfüggvény is.

5. Laplacian kernel - Ez a típusú kernel kevésbé hajlamos a változásokra, és teljesen megegyezik a korábban tárgyalt exponenciális függvénymaggal, a Laplacian kernel egyenlete a következő:

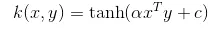

6. Hiperbolikus vagy a Sigmoid kernel - Ezt a kernelet a gépi tanulás ideghálózati területein használják. A szigmoid kernel aktiválási funkciója a bipoláris szigmoid függvény. A hiperbolikus kernelfüggvény egyenlete:

Ez a kernel nagyon használt és népszerű a támogató vektorgépek között.

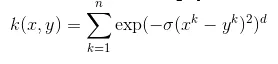

7. Anova sugárirányú kernel - Ez a kernel ismert, hogy nagyon jól alkalmazkodik többdimenziós regressziós problémákhoz, csakúgy, mint a Gauss és Laplacian. Ez a sugárirányú kernel kategóriájába is tartozik.

Az Anova-kernel egyenlete a következő:

Sokkal többféle kernel módszer létezik, és megvitattuk a leginkább használt kerneleket. Ez pusztán a probléma típusától függ, amely eldönti a használandó kernelfunkciót.

Következtetés

Ebben a részben láttuk a kernel definícióját és működését. Ábra segítségével megpróbáltuk elmagyarázni a kernel működését. Ezután megpróbáltunk egy egyszerű szemléltetést adni a matematikai módszerrel a kernel funkciójáról. Az utolsó részben különféle típusú kernelfunkciókat láttunk, amelyeket manapság széles körben használnak.

Ajánlott cikkek

Ez egy útmutató a kernel módszerekhez. Itt tárgyalunk egy bevezetést, annak szükségességét, működését és a kernelmódszerek típusait a megfelelő egyenlettel. A további javasolt cikkeken keresztül további információkat is megtudhat -

- Adatbányászati algoritmusok

- K - klaszterezési algoritmus

- Brute Force algoritmus

- Döntési fa algoritmus

- Kernel módszerek a gépi tanulásban

- Döntési fa a gépi tanulásban