Hogyan lehet telepíteni a kaptárt?

Az Apache Hadoop egy keretrendszer gyűjteménye, amely lehetővé teszi a fürtön át elosztott nagy adatok feldolgozását. Az Apache Hive szerint az Apache Hadoop tetejére épített adattárház-szoftver-projekt az adatok lekérdezésére és elemzésére szolgál. Az Apache kaptár SQL-szerű felületet biztosít nagy mennyiségű adat lekérdezésére és feldolgozására, úgynevezett HQL (Hive query language). Az Apache kaptár fut a Hadoop ökoszisztéma tetején, és a fájl formájában tárolt adatok a Hadoop elosztott fájlrendszerét (HDFS) jelentik. Az Apache Hive nagyszerű felületet biztosít a felhasználó számára az adatokhoz való hozzáféréshez és az adatok táblázatos formában történő végrehajtásához. Ez nagyszerű optimalizálási technikát kínál a teljesítmény javítása érdekében. Nagyon kihívást jelent, hogy nagy lekérdezésekkel gyorsabban végezzük a lekérdezést, és hidd el nekem, ez fontos a termelési környezetben.

A háttérprogramban a fordító konvertálja a HQL lekérdezést térképcsökkentő jobokká, majd beküldi a Hadoop keretrendszerre végrehajtás céljából.

Különbség a Hive és az SQL között

Az Apache Hive nagyon hasonlít az SQL-hez, de mivel tudjuk, hogy a kaptár a Hadoop ökoszisztéma tetején fut, és a munkahelyeket MR-re konvertálja (Map Reduce jobok), különbséget tesz a Hive és az SQL között.

A Hive nem lenne a legjobb megközelítés azokban az alkalmazásokban, ahol nagyon gyors válasz szükséges, és nagyon fontos megérteni, hogy a Hive jobban alkalmazható kötegelt feldolgozásra nagyon nagy változtathatatlan adatkészleteknél, és ezt meg kell jegyeznünk, hogy a Hive rendszeres RDBMS, és végül de nem utolsósorban az apache kaptár az olvasási eszközök sémája (miközben az adatokat a kaptáratáblába illeszti, nem fog zavarni az adattípus eltérése, de az adatok olvasásakor null értéket fog mutatni, ha az adattípus nem egyezik az adott oszlop adattípusával).

A kaptár telepítésének előzetes követelményei

Mint korábban mondtam, nagyon fontos megérteni, hogy az Apache kaptár a Hadoop Ökoszisztéma tetején fut, és a Hadoopnak minden démonnal fel kell készülnie és futnia kell.

Néhány alapvető Hadoop démon a következő:

- Név csomópont

- Adat csomópont

- Erőforrás menedzser

- Csomópontkezelő

Az alábbi Hadoop verzió ellenőrzése:

Írja be a → Hadoop verziót a parancssorba, ez megadja a Hadoop verzióját.

Az alábbi Hadoop-fürt jelentésindító aktiválásának ellenőrzése:

Gépelje be a → Hadoop dfsadmin –report parancsot, amely megadja a teljes fürtjelentést, ha a kiszolgáló fut.

Ha a Hadoop nincs telepítve a számítógépére, kéri, hogy kövesse az apache utasítást a Hadoop telepítéséhez a rendszerre.

Remélem, a Java is telepítve van a rendszerére is. a java verzió ellenőrzéséhez kérjük, olvassa el az alábbi képernyőképet.

A kaptár telepítésének lépései az Ubuntun

Az alábbiakban bemutatjuk a Hive Ubuntu telepítésének lépéseit:

1. lépés : Kaptár tar, amelyet a terminál alábbi parancsával tölthetünk le, közvetlenül a terminálról is letölthetjük.

Parancs: megkapjuk a http://archive.apache.org/dist/hive/hive-2.1.0/apache-hive-2.1.0-bin.tar.gz fájlt

2. lépés : Kicsomagolja a tar fájlt a terminál alábbi parancsával: közvetlenül a kibontott tar tar kaptár tar fájlból kinyerhetjük a tar fájlt.

Parancs: tar -xzf apache-hive-2.1.0-bin.tar.gz

Javaslom, hogy ellenőrizze az extra parancsfájl ls parancsával.

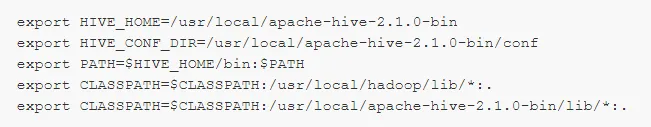

3. lépés: Szerkessze a „ .bashrc ” fájlt, hogy frissítse a felhasználó környezeti változóit.

Parancs: sudo a .bashrc

Adja hozzá a következőt a fájl végéhez:

# Állítsa be a HIVE_HOME elemet

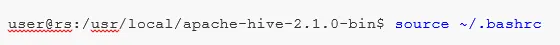

Végezze el az alább megadott parancsot az aktuális terminálon végrehajtott változtatások befejezéséhez.

Parancs: forrás .bashrc

5. lépés : Ki kell hoznunk a Hive könyvtárakat a HDFS helyén, és ebben a „raktárban” a könyvtárban tároljuk a kaptártáblázat metaadataival kapcsolatos információkat és a Hive-vel kapcsolatos adatokat.

Parancs :

- hdfs dfs -mkdir -p / felhasználó / kaptár / raktár

- hdfs dfs -mkdir / tmp

6. lépés : A kaptártáblázat olvasási és írási engedélyének megadásához hajtsa végre az alábbi parancsot.

Parancs:

Az alábbi parancsban írási engedély megadása a felhasználói csoport számára:

- hdfs dfs -chmod g + w / felhasználó / kaptár / raktár

- hdfs dfs -chmod g + w / tmp

A kaptár konfigurálása : Nagyon fontos a kaptár telepítésének pontja, hogy konfigurálhassa a Hadoop programot. Szerkesztenünk kell a hive-env.sh fájlt, amelyet a $ HIVE_HOME / conf könyvtárba helyezünk. A következő parancsok átirányítják a Hive conf mappába, és másolják a sablon fájlt:

7. lépés : Állítsa be a Hadoop elérési útját a hive-env.sh fájlban

Szerkessze a hive-env.sh fájlt a következő sor hozzáadásával:

Most, hogy ez a folyamat már majdnem befejeződött, és a kaptár telepítése sikeresen befejeződött, fontos a Metastore konfigurálása a külső adatbázis szerverrel, és alapértelmezés szerint az Apache Hive keretrendszer Derby adatbázist használ. Az alábbi parancs használatával a Derby adatbázis inicializálása.

Parancs: bin / schematool -initSchema -dbType derby

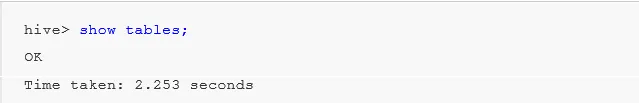

8. lépés : Indítsa el a kaptárt .

Parancs: kaptár (írja be a kaptárt a kaptár második termináljában lévő terminálba.)

Munka a kaptárral : Most láthatjuk a kaptár néhány műveletét, hogy megnézze, hogy hány tábla van az alapértelmezett adatbázis-használatban, lásd az alábbi képernyőképeket az alábbi képernyőképeken, mivel nem jelennek meg táblák, azt jelenti, hogy az alapértelmezett adatbázisban nincs táblázat. .

Táblázat létrehozásához a kaptárban nagyon fontos hivatkozni a szükséges adatbázisra, különben minden táblázat létrejön az alapértelmezett adatbázis alatt.

Fontos parancsok a kaptárban

1. ábra: mutatják be az adatbázisokat (ez megjeleníti az összes eddig létrehozott adatbázist).

2: hozzon létre adatbázist, ha nem létezik mydb (ez a parancs létrehoz egy adatbázist ' mydb' néven, ha ' mydb' nem létezik, és ha ' mydb már létezik, akkor sem fog hibát okozni')

3. ábra: Használjon adatbázist, amikor valamilyen DDl parancsot kell használnunk az adott adatbázison, akkor az „adatbázis használata” parancsot kell használnunk, esetünkben már létrehoztuk a „mydb” show parancsot is használnánk a mydb fájlhoz.

Fontos Hive DDL parancs

Létrehozás, csepegtetés, forgatás, megmutatás, leírás .

- Létrehozás : - Hozzon létre egy kimutatást adatbázis létrehozásához vagy táblázat létrehozásához a kaptárban.

Példa: kaptár> hozzon létre adatbázis-társaságot; (adatbázis létrehozása)

Kaptár> használja a társaságot;

Hive> asztali alkalmazott létrehozása (id int, név String, fizetés String); (ez létre fog hozni a tábla alkalmazottat a vállalati adatbázis alatt, mert már végrehajtottuk az adatbázis használata parancsot.)

- A Leírás információt nyújt a táblázat sémájáról.

Kaptár> írja le az alkalmazottat; (ez megadja a séma részleteit az alkalmazottak táblázata számára)

- A TRUNCATE törli a táblázat adatait.

Kaptár> csonkolja az asztal alkalmazottját;

Telepíthetjük a Kaptárt ablakra is, de a legjobb gyakorlat kedvéért inkább az Ubuntut használom, mert ez jobban áttekintheti a produkciós környezetet, és az Ön adatai a jövőben növekedni fognak, így könnyen kezelhetőek lesznek.

Ajánlott cikkek

Ez egy útmutató a Kaptár telepítéséhez. Itt megvitattuk a Hive, a DDL parancs stb. Telepítésének különféle lépéseit. További tudnivalókat a következő cikkekben is megnézhet:

- Az SQL Server telepítése

- A MATLAB telepítése

- Kaptárparancsok és szolgáltatás

- Alapvető kaptárinterjúval kapcsolatos kérdések

- Kaptárépítés | WorkFlow

- Az ORDER BY funkció használata a kaptárban

- Kaptár telepítése