A Hadoop telepítése áttekintése

A következő cikk, a Hadoop telepítése ismerteti a Hadoop legfontosabb moduljainak leggyakoribb moduljait és a Hadoop lépésről lépésre történő telepítését. Az Apache Hadoop olyan szoftvergyűjtemény, amely lehetővé teszi nagy adatkészletek feldolgozását és elosztott tárolását a számítógépes rendszer különféle típusú csoportjai között. Jelenleg a Hadoop továbbra is a nagy adatok legelterjedtebb elemzési platformja („Sanchita Lobo, az Analytics Training Blog szerzője”).

Hadoop keretrendszer

Az Apache Hadoop keret a következő kulcsmodulokból áll.

- Apache Hadoop Common.

- Apache Hadoop elosztott fájlrendszer (HDFS).

- Apache Hadoop MapReduce

- Apache Hadoop YARN (még egy erőforrás-kezelő).

Apache Hadoop Common

Az Apache Hadoop Common modul megosztott könyvtárakból áll, amelyek az összes többi modulban felhasználásra kerülnek, beleértve a kulcskezelést, az általános I / O csomagokat, a metrikus gyűjtemény könyvtárait és a regisztráció, a biztonság és az adatfolyam segédprogramjait.

HDFS

A HDFS a Google fájlrendszerén alapul, és olcsó hardveren történő futtatásra épül fel. A HDFS tolerálja a hibákat, és nagy adatkészletekkel rendelkező alkalmazásokhoz készült.

MapReduce

A MapReduce az adatfeldolgozás velejáró párhuzamos programozási modellje, és a Hadoop különböző nyelveken, például Java-ban írt MapReduce programokat futtathat. A MapReduce úgy működik, hogy a feldolgozást felosztja a térkép fázisra, és csökkenti a fázist.

Apache Hadoop YARN

Az Apache Hadoop YARN alapvető összetevője, erőforrás-kezelési és feladatütemezési technológia a Hadoop elosztott feldolgozási keretrendszerében.

Ebben a cikkben megvitatjuk a Hadoop 2.7.4 telepítését és konfigurálását egyetlen csomópontfürtön, és teszteljük a konfigurációt a WordRount nevű MapReduce program futtatásával, hogy megszámoljuk a fájlban szereplő szavak számát. Néhány fontos Hadoop fájlrendszer-parancsot tovább vizsgálunk.

A Hadoop telepítésének lépései

Az alábbiakban összefoglaljuk az Apache Hadoop konfigurálásával kapcsolatos feladatokat.

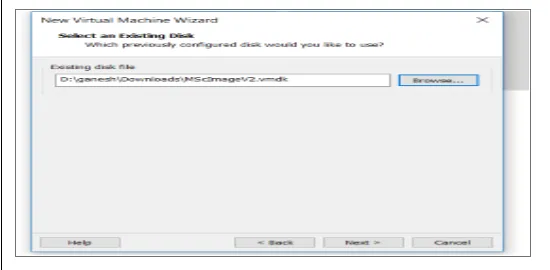

1. feladat: A Hadoop telepítésének első feladata egy virtuális gép sablonjának beállítása volt, amelyet a Cent OS7-rel konfiguráltak. Letöltötték azokat a csomagokat, mint a Java SDK 1.8 és a Runtime Systems, amelyek a Hadoop futtatásához szükségesek, és a Hadoop Java környezeti változóját a bash_rc szerkesztésével konfigurálták.

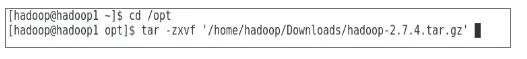

2. feladat: A Hadoop 2.7.4 kiadáscsomagot letöltötték az apache webhelyről, és kibontották az opt mappába. Ezt azután Hadoop-nak nevezték át a könnyű hozzáférés érdekében.

3. feladat: A Hadoop csomagok kibontása után a következő lépés a környezeti változó konfigurálása volt a Hadoop felhasználó számára, majd a Hadoop csomópont XML fájlok konfigurálása. Ebben a lépésben a NameNode konfigurálásra került a core-site.xml belül, a DataNode pedig az hdfs-site.xml fájlon belül. Az erőforrás-kezelőt és a csomópontkezelőt a yarn-site.xml fájlban konfiguráltuk.

4. feladat: A tűzfalat letiltottuk a YARN és a DFS indításához. A JPS parancs segítségével ellenőrizték, hogy a háttérben futnak-e a vonatkozó démonok. A Hadoop eléréséhez szükséges portszámot a következőre konfigurálták: http: // localhost: 50070 /

5. feladat: A következő néhány lépést a Hadoop ellenőrzésére és tesztelésére használtuk. Ehhez létrehoztunk egy ideiglenes tesztfájlt a WordCount program bemeneti könyvtárában. A Hadoop-MapReduce-példa2.7.4.jar térképcsökkentő programot használták a fájlban szereplő szavak számához. Az eredményeket a localhoston értékelték, és a benyújtott pályázat naplóit elemezték. Az összes benyújtott MapReduce alkalmazás megtekinthető az online felületen, alapértelmezett portszáma 8088.

6. feladat: Az utolsó feladatban bemutatunk néhány alapvető Hadoop fájlrendszer-parancsot, és ellenőrizzük azok használatát. Látjuk, hogyan hozhatunk létre egy könyvtárat a Hadoop fájlrendszeren belül, hogy felsoroljuk a könyvtár tartalmát, méretét bájtban. Tovább fogjuk látni, hogyan lehet egy adott könyvtárat és fájlt törölni.

Eredmények a Hadoop telepítésében

Az alábbiakban bemutatjuk a fenti feladatok eredményeit:

Az 1. feladat eredménye

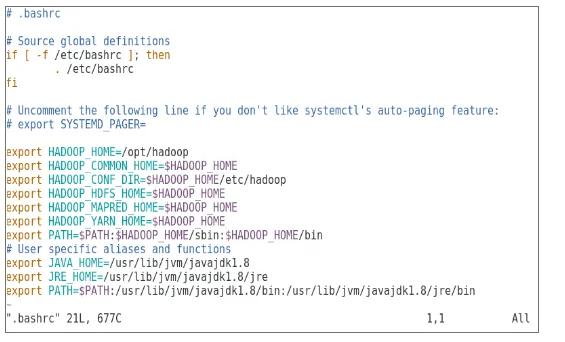

Egy új cenOS7 képpel rendelkező virtuális gépet konfiguráltunk az Apache Hadoop futtatásához. Az 1. ábra azt mutatja, hogy a CenOS 7 kép hogyan lett konfigurálva a virtuális gépen. Az 1.2. Ábra a JAVA környezeti változó konfigurációját mutatja .bash_rc-en belül.

1. ábra: Virtuális gép konfigurációja

1.2 ábra: Java környezeti változó konfigurációja

A 2. feladat eredménye

A 2. ábra a Hadoop 2.7.4 csomag kibontásához az opt mappába történő kibontása érdekében elvégzett feladatot mutatja.

2. ábra: A Hadoop 2.7.4 csomag extrahálása

A 3. feladat eredménye

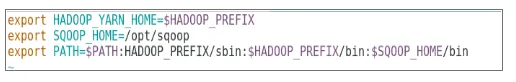

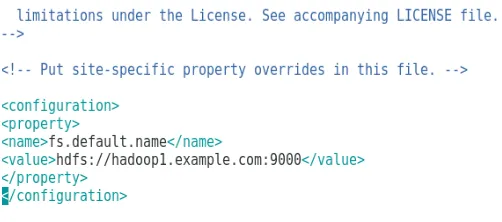

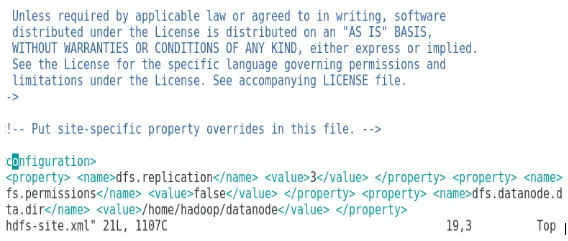

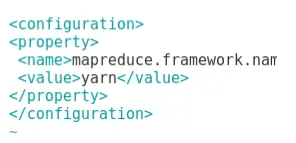

A 3. ábra a környezeti változó konfigurációját mutatja a Hadoop felhasználó számára, a 3.1–4.4. Ábra a XML fájlok konfigurációját mutatja, amelyek a Hadoop konfigurációhoz szükségesek.

3. ábra: A környezeti változó konfigurálása a Hadoop felhasználó számára

3.1 ábra: A core-site.xml konfigurálása

3.2 ábra: Az hdfs-site.xml konfigurálása

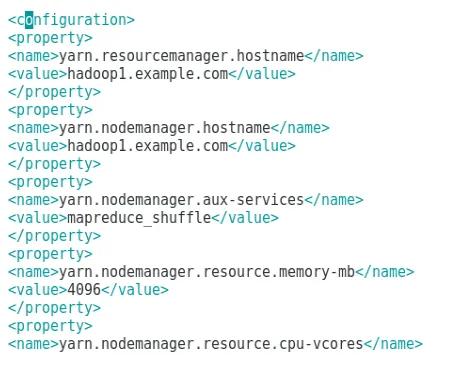

3.3. Ábra: A leképezett site.xml fájl konfigurálása

3.4. Ábra: A fonalak-site.xml fájl konfigurálása

A 4. feladat eredménye

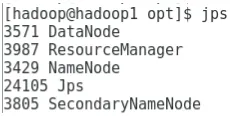

A 4. ábra a jps parancs használatát mutatja a háttérben futó vonatkozó démonok ellenőrzésére, a következő ábra pedig a Hadoop online felhasználói felületét mutatja be.

4. ábra: Jps parancs a futó démonok ellenőrzésére.

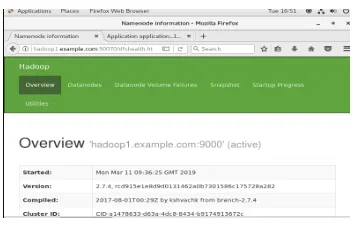

4.1 ábra: A Hadoop online felület elérése a porton http://hadoop1.example.com:50070/

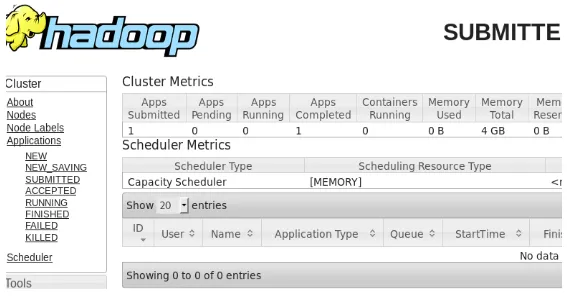

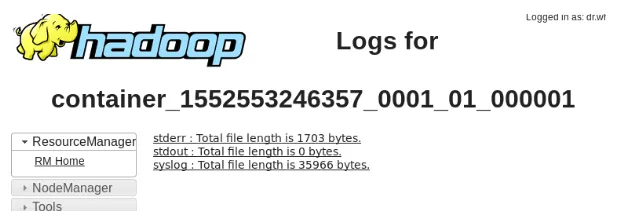

Az 5. feladat eredménye

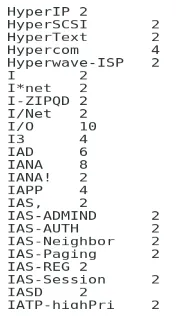

Az 5. ábra a MapReduce program wordcount nevű eredményét mutatja, amely megszámolja a fájlban szereplő szavak számát. A következő pár ábra a YARN erőforrás-kezelő online felhasználói felületét mutatja be a benyújtott feladathoz.

5. ábra: MapReduce program eredményei

5.1 ábra: Elküldött térképcsökkentő alkalmazás.

5.2 ábra: A benyújtott MapReduce alkalmazás naplói.

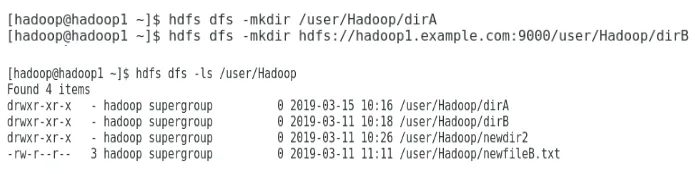

A 6. feladat eredménye

A 6. ábra bemutatja, hogyan lehet létrehozni egy könyvtárat a Hadoop fájlrendszerben, és hogyan kell felsorolni az hdfs könyvtárat.

6. ábra: Könyvtár létrehozása a Hadoop fájlrendszerben

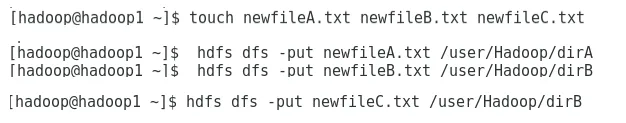

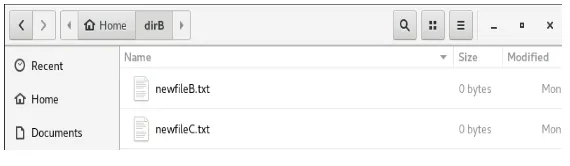

A 6.1. Ábra bemutatja, hogyan kell egy fájlt elhelyezni a Hadoop elosztott fájlrendszerére, a 6.2. Ábra pedig a létrehozott fájlt mutatja a dirB könyvtárban.

6.1. Ábra: Fájl létrehozása HDFS-ben.

6.2 ábra: Új fájl létrehozva.

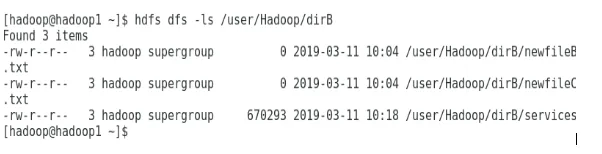

A következő néhány ábra bemutatja, hogyan kell felsorolni az egyes könyvtárak tartalmát:

6.3. Ábra: A dirA tartalma

6.4. Ábra: A dirB tartalma

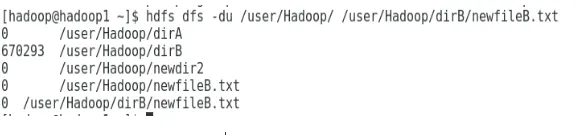

A következő ábra bemutatja, hogyan jeleníthető meg a fájl és a könyvtár mérete:

6.5 ábra: A fájl és a könyvtár méretének megjelenítése.

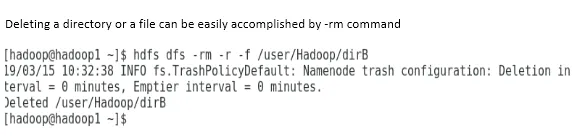

A könyvtár vagy a fájl törlése az -rm paranccsal egyszerűen végrehajtható.

6.6. Ábra: Fájl törlése.

Következtetés

A Big Data nagyon fontos szerepet játszott a mai világpiac kialakításában. A Hadoop keretrendszer megkönnyíti az elemző életét, miközben nagy adatkészleteken dolgozik. Az Apache Hadoop konfigurálása meglehetősen egyszerű volt, és az online felhasználói felület több lehetőséget biztosított a felhasználó számára az alkalmazás hangolására és kezelésére. A Hadoop-ot széles körben használják szervezetekben adattároláshoz, gépi tanulási elemzéshez és az adatok biztonsági mentéséhez. Nagy mennyiségű adat kezelése meglehetősen praktikus volt a Hadoop elosztott környezete és a MapReduce miatt. A Hadoop fejlesztése elég elképesztő volt a relációs adatbázisokkal összehasonlítva, mivel hiányoznak a hangolási és a teljesítmény lehetőségek. Az Apache Hadoop felhasználóbarát és olcsó megoldás a nagy adatok hatékony kezelésére és tárolására. A HDFS nagy segítséget nyújt az adatok tárolásában is.

Ajánlott cikkek

Ez egy útmutató a Hadoop telepítéséhez. Itt tárgyaljuk az Instal Hadoop bevezetését, a Hadoop lépésről lépésre történő telepítését, valamint a Hadoop telepítésének eredményeit. A további javasolt cikkeken keresztül további információkat is megtudhat -

- Bevezetés a Hadoop adatfolyamba

- Mi a Hadoop klaszter és hogyan működik?

- Apache Hadoop ökoszisztéma és alkatrészei

- Melyek a Hadoop alternatívái?