Mi a Big Data Technology?

Mint tudjuk, az adatok folyamatosan fejlődnek. Az adatok növekedése kihívást jelentett az emberi elmék számára annak kinyerésére, elemzésére és kezelésére. Ennek oka az, hogy az adatkezelés hagyományos módszerei nem támogatják ezt a nagy adatot. A nagy adatokat általában három fogalom jellemzi: térfogat, változatosság és sebesség.

Az adatok minden társaság legfontosabb eszközévé váltak. E nagy adatok elemzése segíti a társaságot az ügyfelek viselkedésének elemzésében és az ehhez kapcsolódó lényeges dolgok előrejelzésében. Az adatvezérelt döntések a szervezetet megalapozzák, magabiztosabb lépéseket tesznek és erősebb stratégiákat építhetnek fel.

Tudva az adatok növekedésének ütemét a mai korszakban, a nagy adatok a közeljövőben óriási mező lesz, amelyeken dolgozni fognak. Minden hallgatónak, frissítőnek és szakembereknek szükségük van arra, hogy naprakészen tartsák a feltörekvő nagy adattechnológiákat. Tartsa naprakészen egy nagyszerű és sikeres karriert a szakmai pályán.

Big Data Technologies

Itt felsorolom néhány nagy adattechnológiát, egyértelmű magyarázattal, hogy tudatában legyen a közelgő trendekkel és a technológiával:

-

Apache Spark:

Ez egy gyors, nagy adatfeldolgozó motor. Ezt a valós idejű adatfeldolgozás szem előtt tartásával építettük fel. Gazdag gépi tanulási könyvtára jó az AI és az ML területén. Párhuzamosan és fürtözött számítógépeken dolgozza fel az adatokat. A Spark által használt alaptípus az RDD (rugalmas elosztott adatkészlet).

-

NoSQL adatbázisok:

Nem relációs adatbázisok biztosítják az adatok gyors tárolását és visszakeresését. Egyedülálló az a képessége, hogy bármilyen adatot kezeljen, mint például a strukturált, félig strukturált, nem strukturált és polimorf adatok. Egyik SQL-adatbázis sem a következő típusú:

- Dokumentum-adatbázisok : Az adatokat dokumentumok formájában tárolja, amelyek sok különféle kulcs-érték párt tartalmazhatnak.

- Grafikon tárolja : Adatokat tárol, amelyeket általában a hálózat formájában tárol, például a közösségi média adatait.

- Kulcsérték-tárolók : Ezek a legegyszerűbb NoSQL adatbázisok. Az adatbázisban minden egyes elemet attribútumnévként (vagy 'kulcsként') tárolnak annak értékével együtt.

- Széles oszlopok tárolása : Ez az adatbázis az adatokat oszlop formátumban, nem pedig sor alapú formátumban tárolja. A Cassandra és a HBase jó példák erre.

-

Apache Kafka:

A Kafka egy elosztott esemény streaming platform, amely minden nap sok eseményt kezel. Mivel gyors és méretezhető, ez hasznos az olyan valós idejű adatfolyam-építés során, amely megbízhatóan szolgáltat adatokat az egyes rendszerek vagy alkalmazások között.

-

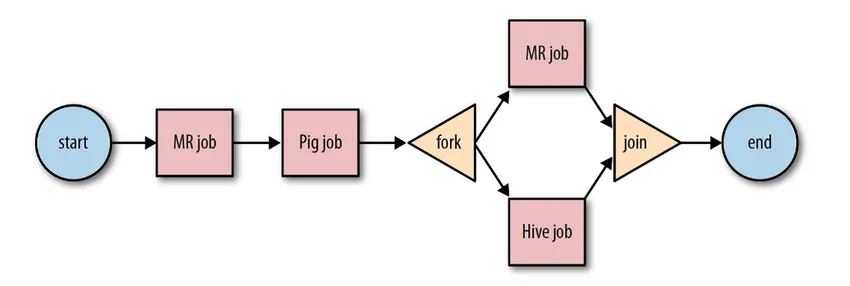

Apache Oozie:

Ez egy munkafolyamat-ütemező rendszer a Hadoop feladatok kezelésére. Ezeket a munkafolyamat-feladatokat irányított aciklikus grafikonok (DAG) formájában ütemezzük a műveletekhez.

Forrás: Google

Méretezhető és szervezett megoldása nagy adatforgalmi tevékenységekhez.

-

Apache Airflow:

Ez egy olyan platform, amely ütemezi és figyeli a munkafolyamatot. Az intelligens ütemezés segít a projekt hatékony végrehajtásának megszervezésében. Az Airflow képes egy DAG-példány újrafuttatására, ha hiba van. Gazdag felhasználói felülete megkönnyíti a különböző szakaszokban futó csővezetékek megjelenítését, például a gyártást, az előrehaladás figyelését és a problémák elhárítását, ha szükséges.

-

Apache Beam:

Ez egy egységes modell, amely meghatározza és végrehajtja az adatfeldolgozási csővezetékeket, amelyek tartalmazzák az ETL-t és a folyamatos adatfolyamot. Az Apache Beam keretrendszer absztrakciót nyújt az alkalmazás logikája és a nagy adatökoszisztéma között, mivel nem létezik olyan API, amely megköti az összes keretet, például Hadoop, spark stb.

-

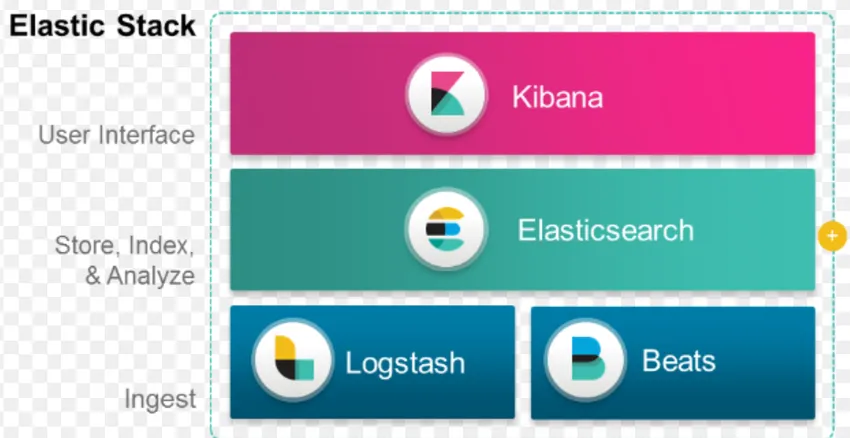

ELK Stack:

Az ELK az Elasticsearch, a Logstash és a Kibana ismert.

Az Elasticsearch egy séma nélküli adatbázis (amely minden mezőt indexel), amely hatékony keresési lehetőségekkel rendelkezik és könnyen méretezhető.

A Logstash egy ETL eszköz, amely lehetővé teszi az események letöltését, átalakítását és tárolását az Elasticsearch fájlba.

A Kibana egy műszerfal eszköz az Elasticsearch számára, ahol elemezheti az összes tárolt adatot. A Kibanától kivitelezhető gyakorlati betekintés segít a szervezet stratégiáinak felépítésében. A változások rögzítésétől az előrejelzésig a Kibana mindig nagyon hasznosnak bizonyult.

-

Docker és Kubernete:

Ezek a megjelenő technológiák, amelyek elősegítik az alkalmazások Linux konténerekben való futását. A Docker egy nyílt forráskódú eszközgyűjtemény, amely segít „Bármely alkalmazás létrehozása, szállítása és futtatása bárhol”.

A Kubernetes egy nyílt forráskódú konténer / zenekari platform is, amely nagyszámú konténer számára lehetővé teszi a harmonikus működést. Ez végül csökkenti az üzemeltetési terheket.

-

TensorFlow:

Ez egy nyílt forráskódú gépi tanulási könyvtár, amelyet mélyreható modellek tervezésére, felépítésére és kiképzésére használnak. Minden számítást a TensorFlow-ban végezzünk, adatáramlási grafikonokkal. A grafikonok csomópontokat és éleket tartalmaznak. A csomópontok a matematikai műveleteket, míg a szélek az adatokat képviselik.

A TensorFlow hasznos a kutatásban és a termelésben. Úgy tervezték, hogy szem előtt tartva, hogy több CPU-n vagy GPU-n és akár mobil operációs rendszeren is futhat. Ez megvalósítható Python, C ++, R és Java nyelven.

-

Gyors:

A Presto egy nyílt forráskódú SQL motor, amelyet a Facebook fejlesztett ki, és képes az adatok petatabátusának kezelésére. A Hive-től eltérően a Presto nem függ a MapReduce technikától, így gyorsabban tudja letölteni az adatokat. Felépítése és interfésze elég könnyű ahhoz, hogy más fájlrendszerekkel kölcsönhatásba lépjen.

Az alacsony késleltetés és az interaktív lekérdezés miatt manapság nagyon népszerűvé válik a nagy adatok kezelése.

-

Polybase:

A Polybase az SQL Server tetején működik, hogy hozzáférjen a PDW-ben (Parallel Data Warehouse) tárolt adatokhoz. A PDW bármilyen mennyiségű relációs adat feldolgozására készült, és a Hadoop-nal integrálható.

-

Kaptár:

A kaptár egy olyan platform, amelyet nagy adatkészleteknél lekérdezéshez és adatelemzéshez használnak. Biztosít egy SQL-szerű lekérdezési nyelvet, HiveQL néven, amelyet belsőleg MapReduce-ba konvertálnak, majd feldolgoznak.

Az adatok gyors növekedése és a szervezet hatalmas törekvése a nagy adatok elemzésére törekszik arra, hogy a technológia annyi érlelt technológiát hozott a piacra, hogy ezek ismerete óriási előnyt jelent. Manapság a Big data Technology számos üzleti igényt és problémát megválaszol azáltal, hogy növeli a működési hatékonyságot és megjósolja a vonatkozó viselkedést. A nagy adatok karrierje és az ahhoz kapcsolódó technológia számos lehetőségeket nyithat meg az emberek és a vállalkozások számára.

Mostantól itt az ideje, hogy átvegyék a nagy adattechnológiákat.

Ajánlott cikkek

Ez egy útmutató a Mi az a Big Data Technology című cikkben. Itt tárgyalt néhány nagy adattechnológiát, például a Hive, az Apache Kafka, az Apache Beam, az ELK Stack stb. További tudnivalókat a következő cikkben találhat -

- Mi az a mély tanulás?

- Útmutató a Minitab-hoz?

- Mi az a Salesforce technológia?

- Mi a nagy adatanalitika?