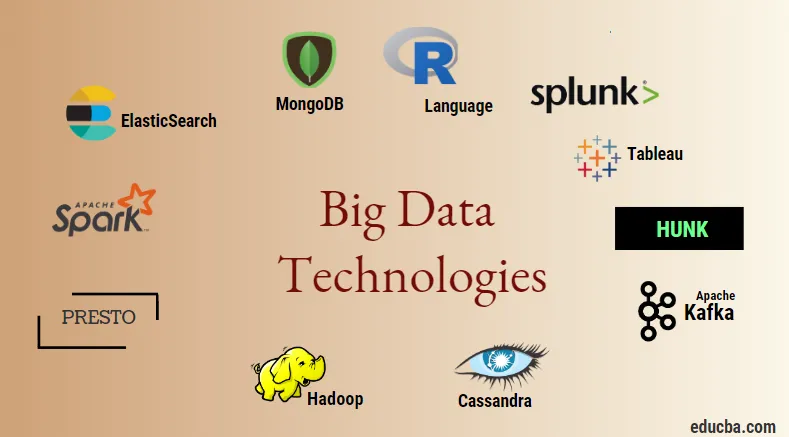

Bevezetés a nagy adattechnológiákba

Nagy adattechnológia és a Hadoop nagy szóbeszéd, mivel hangzik. Mivel az ipar és az iparágak óriási növekedése mutatkozik az adat- és információtartományban, nagyon fontos egy hatékony technika bevezetése és bevezetése, amely gondoskodik az ügyfelek és az adatgyűjtésért felelős nagyipar igényeiről és igényeiről. . Korábban az adatokat a normál programozási nyelvek és az egyszerű strukturált lekérdezési nyelv kezelték, de most úgy tűnik, hogy ezek a rendszerek és eszközök nem tesznek nagyot nagy adatok esetén. A nagy adatátviteli technológiát úgy definiálják, mint az a technológia és szoftver segédprogram, amelyet az információk elemzésére, feldolgozására és kinyerésére terveztek egy rendkívül összetett szerkezetből és nagy adathalmazból, amely a hagyományos rendszerek számára nagyon nehéz kezelni. A big data technológiát mind a valós idejű, mind a kötegelt adatok kezelésére használják. A gépi tanulás a mindennapi élet és minden iparág nagyon kritikus elemévé vált, ezért az adatok nagy adatokon keresztüli kezelése nagyon fontos.

A nagy adattechnológiák típusai

Mielőtt elkezdenénk a technológiák felsorolását, először nézzük meg mindezen technológiák átfogó osztályozását. Elsősorban négy domainbe lehet besorolni.

- Adattárolás

- Analitika

- Adatbányászat

- Megjelenítés

Először fedezzük fel az összes technológiát, amelyek a tárolás égisze alatt állnak.

1. Hadoop : A nagy adatokkal kapcsolatban a Hadoop az első technológia, amely a játékba kerül. Ez a térképcsökkentő architektúrán alapul, és elősegíti a kötegelt feladatok feldolgozását és a kötegelt adatok feldolgozását. Úgy tervezték, hogy az adatokat egy elosztott adatfeldolgozó környezetben tárolja és feldolgozza, az árucikk-hardverrel és egy egyszerű programozási végrehajtási modellel együtt. Használható az adatok tárolására és elemzésére különféle gépekben, nagy tárolási, sebességű és alacsony költségekkel. Ez a nagy adattechnológia egyik fő alkotóeleme, amelyet az Apache szoftverfejlesztési alapítvány fejlesztett ki 2011-ben, és a Java nyelven írja.

1. Hadoop : A nagy adatokkal kapcsolatban a Hadoop az első technológia, amely a játékba kerül. Ez a térképcsökkentő architektúrán alapul, és elősegíti a kötegelt feladatok feldolgozását és a kötegelt adatok feldolgozását. Úgy tervezték, hogy az adatokat egy elosztott adatfeldolgozó környezetben tárolja és feldolgozza, az árucikk-hardverrel és egy egyszerű programozási végrehajtási modellel együtt. Használható az adatok tárolására és elemzésére különféle gépekben, nagy tárolási, sebességű és alacsony költségekkel. Ez a nagy adattechnológia egyik fő alkotóeleme, amelyet az Apache szoftverfejlesztési alapítvány fejlesztett ki 2011-ben, és a Java nyelven írja.

2. MongoDB : A nagy adattechnológia egy másik nagyon fontos és alapvető alkotóeleme a tárolás szempontjából a MongoDB NoSQL adatbázis. NoSQL adatbázis, ami azt jelenti, hogy a relációs tulajdonságok és az egyéb RDBMS-rel kapcsolatos tulajdonságok nem vonatkoznak rá. Ez különbözik a hagyományos RDBMS adatbázisoktól, amelyek strukturált lekérdezési nyelvet használnak. Sémadokumentumokat használ, az adattárolás felépítése szintén eltér, ezért nagy mennyiségű adat tárolásához hasznosak. Ez egy platformközi, dokumentum-orientált tervező és adatbázis program, amely a JSON-típusú dokumentumokat és a sémát használja. Ez a pénzügyi intézmények többségében nagyon hasznos operatív adattárolássá válik, ezáltal a hagyományos mainframek helyett. A MongoDB a rugalmasságot és az adattípusok széles skáláját kezeli nagy mennyiségben és az elosztott architektúrák között.

2. MongoDB : A nagy adattechnológia egy másik nagyon fontos és alapvető alkotóeleme a tárolás szempontjából a MongoDB NoSQL adatbázis. NoSQL adatbázis, ami azt jelenti, hogy a relációs tulajdonságok és az egyéb RDBMS-rel kapcsolatos tulajdonságok nem vonatkoznak rá. Ez különbözik a hagyományos RDBMS adatbázisoktól, amelyek strukturált lekérdezési nyelvet használnak. Sémadokumentumokat használ, az adattárolás felépítése szintén eltér, ezért nagy mennyiségű adat tárolásához hasznosak. Ez egy platformközi, dokumentum-orientált tervező és adatbázis program, amely a JSON-típusú dokumentumokat és a sémát használja. Ez a pénzügyi intézmények többségében nagyon hasznos operatív adattárolássá válik, ezáltal a hagyományos mainframek helyett. A MongoDB a rugalmasságot és az adattípusok széles skáláját kezeli nagy mennyiségben és az elosztott architektúrák között.

3. Hunk : Hasznos az adatok távoli Hadoop-fürtökön keresztüli elérésében virtuális indexek felhasználásával, valamint a Splunk keresés feldolgozási nyelvét is használja, amely felhasználható az adatok elemzésére. A darab felhasználható hatalmas mennyiségű adat jelentésére és megjelenítésére a Hadoop és a NoSQL adatbázisokból és forrásokból. A Splunk csapata fejlesztette ki 2013-ban, Java nyelven.

3. Hunk : Hasznos az adatok távoli Hadoop-fürtökön keresztüli elérésében virtuális indexek felhasználásával, valamint a Splunk keresés feldolgozási nyelvét is használja, amely felhasználható az adatok elemzésére. A darab felhasználható hatalmas mennyiségű adat jelentésére és megjelenítésére a Hadoop és a NoSQL adatbázisokból és forrásokból. A Splunk csapata fejlesztette ki 2013-ban, Java nyelven.

4. Cassandra : A Cassandra kiemelt választást jelent a népszerű NoSQL adatbázisok között, amely egy ingyenes és nyílt forrású adatbázis, amelyet szétszórtak, széles oszlopos tárolással és hatékonyan kezelni tudják a nagy árucsoportok adatait, azaz megszokták magas rendelkezésre állást biztosítanak, egyetlen hibapont nélkül. A fő jellemzők között szerepelnek például az elosztott természet, a skálázhatóság, a hibatűrő mechanizmus, a MapReduce támogatás, a hangolható konzisztencia, a lekérdezési nyelv tulajdonságai, támogatják a több adatközpont replikációját és az esetleges konzisztenciát.

4. Cassandra : A Cassandra kiemelt választást jelent a népszerű NoSQL adatbázisok között, amely egy ingyenes és nyílt forrású adatbázis, amelyet szétszórtak, széles oszlopos tárolással és hatékonyan kezelni tudják a nagy árucsoportok adatait, azaz megszokták magas rendelkezésre állást biztosítanak, egyetlen hibapont nélkül. A fő jellemzők között szerepelnek például az elosztott természet, a skálázhatóság, a hibatűrő mechanizmus, a MapReduce támogatás, a hangolható konzisztencia, a lekérdezési nyelv tulajdonságai, támogatják a több adatközpont replikációját és az esetleges konzisztenciát.

Ezután beszéljünk a nagy adattechnológia különféle területeiről, azaz az adatbányászatról.

5. Presto : Ez egy népszerű nyílt forráskódú és SQL alapú elosztott lekérdezési motor, amelyet interaktív lekérdezések futtatására használnak minden méretarányú adatforrás ellen, és a méret gigabájt és petabájt közötti tartományba esik. Segítségével az adatok lekérdezésére a Cassandra, a Hive, a saját tulajdonú adattárolók és a relációs adatbázis-tároló rendszerek területén férhetünk hozzá. Ez egy java alapú lekérdező motor, amelyet az Apache Alapítvány fejlesztett ki 2013-ban. A Presto eszközt jól hasznosító cégek néhány csoportja a Netflix, az Airbnb, a Checkr, a Repro és a facebook.

5. Presto : Ez egy népszerű nyílt forráskódú és SQL alapú elosztott lekérdezési motor, amelyet interaktív lekérdezések futtatására használnak minden méretarányú adatforrás ellen, és a méret gigabájt és petabájt közötti tartományba esik. Segítségével az adatok lekérdezésére a Cassandra, a Hive, a saját tulajdonú adattárolók és a relációs adatbázis-tároló rendszerek területén férhetünk hozzá. Ez egy java alapú lekérdező motor, amelyet az Apache Alapítvány fejlesztett ki 2013-ban. A Presto eszközt jól hasznosító cégek néhány csoportja a Netflix, az Airbnb, a Checkr, a Repro és a facebook.

6. ElasticSearch : Ez manapság nagyon fontos eszköz a keresésnél . Ez az ELK verem lényeges alkotóeleme, azaz a rugalmas keresés, a Logstash és a Kibana. Az ElasticSearch egy Lucene könyvtár alapú keresőmotor, amely hasonló a Solrhoz, és tisztán elosztott, teljes szövegű keresőmotor biztosítására szolgál, amely több bérlő képes. Van sémamentes JSON-dokumentumok listája és egy HTTP webes felület. A JAVA nyelven íródott, és az Elastic cég fejlesztette ki a 2012-es társaságban. Néhány, az elasztikus keresést igénybe vevő cég neve: LinkedIn, StackOverflow, Netflix, facebook, google, Accenture stb.

6. ElasticSearch : Ez manapság nagyon fontos eszköz a keresésnél . Ez az ELK verem lényeges alkotóeleme, azaz a rugalmas keresés, a Logstash és a Kibana. Az ElasticSearch egy Lucene könyvtár alapú keresőmotor, amely hasonló a Solrhoz, és tisztán elosztott, teljes szövegű keresőmotor biztosítására szolgál, amely több bérlő képes. Van sémamentes JSON-dokumentumok listája és egy HTTP webes felület. A JAVA nyelven íródott, és az Elastic cég fejlesztette ki a 2012-es társaságban. Néhány, az elasztikus keresést igénybe vevő cég neve: LinkedIn, StackOverflow, Netflix, facebook, google, Accenture stb.

Olvassa el most mindazokat a nagy adatszolgáltatási technológiákat, amelyek az Adatelemzés részét képezik:

7. Apache Kafka : A közzétételre-feliratkozásra vagy a pub-subre ismert, mivel közismert néven ismert, egy közvetlen üzenetküldő, aszinkron üzenetküldő bróker-rendszer, amelyet valós idejű adatfolyamok feldolgozására és feldolgozására használnak. Ezenkívül előírja a megőrzési időtartamot, és az adatokat a termelő-fogyasztó mechanizmus segítségével lehet csatornázni. Ez az egyik legnépszerűbb streaming platform, amely nagyon hasonló a vállalati üzenetküldő rendszerhez vagy az üzenetküldési sorhoz. A Kafka eddig számos fejlesztést indított el, és az egyik fő fajtája a Kafka összefolyó része, amely további szintű tulajdonságokat biztosít a Kafka számára, mint például a Schema nyilvántartás, a Ktables, a KSql stb. Az Apache Software közösség fejlesztette ki 2011-ben, és a Java nyelven íródott. A technológiát alkalmazó vállalatok közé tartozik a Twitter, a Spotify, a Netflix, a Linkedin, a Yahoo stb.

7. Apache Kafka : A közzétételre-feliratkozásra vagy a pub-subre ismert, mivel közismert néven ismert, egy közvetlen üzenetküldő, aszinkron üzenetküldő bróker-rendszer, amelyet valós idejű adatfolyamok feldolgozására és feldolgozására használnak. Ezenkívül előírja a megőrzési időtartamot, és az adatokat a termelő-fogyasztó mechanizmus segítségével lehet csatornázni. Ez az egyik legnépszerűbb streaming platform, amely nagyon hasonló a vállalati üzenetküldő rendszerhez vagy az üzenetküldési sorhoz. A Kafka eddig számos fejlesztést indított el, és az egyik fő fajtája a Kafka összefolyó része, amely további szintű tulajdonságokat biztosít a Kafka számára, mint például a Schema nyilvántartás, a Ktables, a KSql stb. Az Apache Software közösség fejlesztette ki 2011-ben, és a Java nyelven íródott. A technológiát alkalmazó vállalatok közé tartozik a Twitter, a Spotify, a Netflix, a Linkedin, a Yahoo stb.

8. Splunk : Az Splunk felhasználásával valós idejű adatfolyamokat rögzíthet, korrelálhat és indexelhet egy kereshető adattárból, ahonnan jelentéseket, grafikonokat, műszerfalakat, riasztásokat és adatmegjelenítéseket generálhat. Biztonsághoz, megfeleléshez és alkalmazáskezeléshez, valamint webes elemzéshez, üzleti betekintés generálásához és üzleti elemzéshez is felhasználják. A Splunk fejlesztette ki Pythonban, XML, Ajax.

8. Splunk : Az Splunk felhasználásával valós idejű adatfolyamokat rögzíthet, korrelálhat és indexelhet egy kereshető adattárból, ahonnan jelentéseket, grafikonokat, műszerfalakat, riasztásokat és adatmegjelenítéseket generálhat. Biztonsághoz, megfeleléshez és alkalmazáskezeléshez, valamint webes elemzéshez, üzleti betekintés generálásához és üzleti elemzéshez is felhasználják. A Splunk fejlesztette ki Pythonban, XML, Ajax.

9. Apache Spark : Most jön a legkritikusabb és legjobban várt technológia a nagy adattechnológiák területén, azaz az Apache Spark. Valószínűleg az egyik a legkeresettebb manapság, és feldolgozásához Java, Scala vagy Python felhasználást használ. Ezzel a valós idejű adatfolyam-feldolgozásra és -kezelésre szolgál a Spark Streaming segítségével, amely kötegelt és ablakos műveleteket használ ennek végrehajtására. A Spark SQL adatkeretek, adatkészletek létrehozására szolgál az RDD-k tetején, és ezzel jó ízű transzformációkat és műveleteket eredményez, amelyek az Apache Spark Core szerves részét képezik. Más komponensek, például a Spark Mllib, R és a graphX szintén hasznosak elemzés, gépi tanulás és adattudomány elvégzésekor. A memóriában lévő számítástechnika különbözteti meg más eszközöktől és alkatrészektől, és az alkalmazások széles skáláját támogatja. Ezt az Apache Software Alapítvány fejlesztette ki elsősorban Java nyelven.

9. Apache Spark : Most jön a legkritikusabb és legjobban várt technológia a nagy adattechnológiák területén, azaz az Apache Spark. Valószínűleg az egyik a legkeresettebb manapság, és feldolgozásához Java, Scala vagy Python felhasználást használ. Ezzel a valós idejű adatfolyam-feldolgozásra és -kezelésre szolgál a Spark Streaming segítségével, amely kötegelt és ablakos műveleteket használ ennek végrehajtására. A Spark SQL adatkeretek, adatkészletek létrehozására szolgál az RDD-k tetején, és ezzel jó ízű transzformációkat és műveleteket eredményez, amelyek az Apache Spark Core szerves részét képezik. Más komponensek, például a Spark Mllib, R és a graphX szintén hasznosak elemzés, gépi tanulás és adattudomány elvégzésekor. A memóriában lévő számítástechnika különbözteti meg más eszközöktől és alkatrészektől, és az alkalmazások széles skáláját támogatja. Ezt az Apache Software Alapítvány fejlesztette ki elsősorban Java nyelven.

10. R nyelv : R egy programozási nyelv és egy ingyenes szoftverkörnyezet, amelyet statisztikai számításhoz és grafikához is használnak az R egyik legfontosabb nyelvén. Ez az egyik a legnépszerűbb nyelv az adattudósok, az adatkezelők és az adatkutatók között. adatgyakorlók statisztikai szoftverek fejlesztésére és főként az adatok elemzésére.

10. R nyelv : R egy programozási nyelv és egy ingyenes szoftverkörnyezet, amelyet statisztikai számításhoz és grafikához is használnak az R egyik legfontosabb nyelvén. Ez az egyik a legnépszerűbb nyelv az adattudósok, az adatkezelők és az adatkutatók között. adatgyakorlók statisztikai szoftverek fejlesztésére és főként az adatok elemzésére.

Most tárgyaljuk az adatmegjelenítéshez kapcsolódó technológiákat.

11. Tableau: Ez a leggyorsabb és leghatékonyabban növekvő adatmegjelenítő eszköz, amelyet az üzleti intelligencia területén használnak. Az adatelemzés egy nagyon gyors gép, amely a Tableau segítségével lehetséges, és a vizualizációk munkalapok és műszerfalak formájában készülnek. A tableau cég fejlesztette ki 2013-ban, Python, C ++, Java és C nyelven írva. A Tableau szolgáltatást használó cégek: QlikQ, Oracle Hyperion, Cognos stb.

11. Tableau: Ez a leggyorsabb és leghatékonyabban növekvő adatmegjelenítő eszköz, amelyet az üzleti intelligencia területén használnak. Az adatelemzés egy nagyon gyors gép, amely a Tableau segítségével lehetséges, és a vizualizációk munkalapok és műszerfalak formájában készülnek. A tableau cég fejlesztette ki 2013-ban, Python, C ++, Java és C nyelven írva. A Tableau szolgáltatást használó cégek: QlikQ, Oracle Hyperion, Cognos stb.

12. Plotly : A Plotly-t elsősorban a Grafikonok és a kapcsolódó komponensek gyorsabbá és hatékonyabbá tételéhez használják. Gazdagabb könyvtárakkal és API-kkal rendelkezik, például MATLAB, Python, R, Arduino, Julia stb. Ez interaktív módon használható a Jupyter notebookban és a Pycharmban, és felhasználható az interaktív grafikonok stílusához. Először 2012-ben fejlesztették ki, és javascript-ben írták. A Plotlyt használó néhány vállalat a paladinok, a bitbank stb.

12. Plotly : A Plotly-t elsősorban a Grafikonok és a kapcsolódó komponensek gyorsabbá és hatékonyabbá tételéhez használják. Gazdagabb könyvtárakkal és API-kkal rendelkezik, például MATLAB, Python, R, Arduino, Julia stb. Ez interaktív módon használható a Jupyter notebookban és a Pycharmban, és felhasználható az interaktív grafikonok stílusához. Először 2012-ben fejlesztették ki, és javascript-ben írták. A Plotlyt használó néhány vállalat a paladinok, a bitbank stb.

Következtetés

Ebben a bejegyzésben megvizsgáltuk a mai széles körben alkalmazott nagy adat-technológiákat. Remélem tetszett. Kövess minket további ilyen jellegű hozzászólásokhoz.

Ajánlott cikkek

Ez a Big Data Technologies útmutatója. Itt megvitatjuk a Big Data Technologies bevezetését és típusait. A további javasolt cikkeken keresztül további információkat is megtudhat -

- Mi az a Splunk eszköz?

- R vs Python

- Mi a Matlab?

- Mi az a MongoDB?

- A nagygépek tesztelésében követendő lépések

- Csatlakozás típusai a Spark SQL-ben (példák)

- Ismerje meg a Kafka eszközök különféle típusait