Bevezetés az AdaBoost algoritmusba

Az AdaBoost algoritmus felhasználható bármilyen gépi tanulási algoritmus teljesítményének fokozására. A gépi tanulás hatékony eszközévé vált, amely nagy mennyiségű adat alapján előrejelzéseket tud készíteni. Az utóbbi időben annyira népszerűvé vált, hogy a gépi tanulás alkalmazható mindennapi tevékenységeinkben. Általános példa erre a termékekre vonatkozó javaslatok megszerzése online vásárlás közben, az ügyfél által vásárolt múltbéli termékek alapján. A gépi tanulás, amelyet gyakran prediktív elemzésnek vagy prediktív modellezésnek is neveznek, úgy határozható meg, hogy a számítógépek képesek tanulni anélkül, hogy kifejezetten programoznák őket. Beprogramozott algoritmusokat használ a bemeneti adatok elemzésére, hogy a kimenetet elfogadható tartományon belül megjósolja.

Mi az AdaBoost algoritmus?

A gépi tanulásban a fellendülés abból a kérdésből származott, hogy a gyenge osztályozók halmaza átalakítható-e erős osztályozóvá. A gyenge tanuló vagy osztályozó olyan tanuló, amely jobb, mint a véletlenszerű kitalálás, és ez erőteljes lesz a túl illeszkedéshez, mint egy nagy sor gyenge osztályozóhoz, minden gyenge osztályozó jobb, mint a véletlenszerű. Gyenge osztályozóként általában egyetlen jellemző egyszerű küszöbértékét alkalmazzák. Ha a tulajdonság meghaladja a várt küszöböt, akkor a pozitívhoz tartozik, egyébként a negatívhoz tartozik.

Az AdaBoost az „Adaptive Boosting” kifejezést jelenti, amely a gyenge tanulókat vagy prediktorokat erős prediktorokká alakítja át az osztályozási problémák megoldása érdekében.

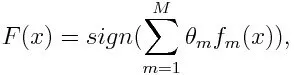

A besoroláshoz a végleges egyenletet az alábbiak szerint lehet összeállítani:

Itt f m jelöli az m- es gyenge osztályozót, és m jelöli a megfelelő súlyt.

Hogyan működik az AdaBoost algoritmus?

Az AdaBoost felhasználható a gépi tanulási algoritmusok teljesítményének javítására. Legjobban gyenge tanulókkal alkalmazzák, és ezek a modellek nagy pontosságot érnek el a véletlenszerű esélyek felett egy osztályozási problémán. Az AdaBoost által használt algoritmusok első szintű döntési fák. A gyenge tanuló olyan osztályozó vagy prediktor, amelynek pontossága viszonylag gyenge. Azt is feltételezhetjük, hogy a gyenge tanulókat egyszerűen kiszámolhatjuk, és számos algoritmus példányt kombinálunk egy erős osztályozó létrehozására a növelés révén.

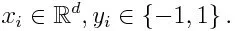

Ha vettünk egy n számú pontot tartalmazó adatkészletet, vegye figyelembe az alábbiakat

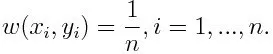

-1 jelentése negatív osztály, 1 pedig pozitív. Az inicializálás az alábbiak szerint történik, az egyes adatpontok súlya a következő:

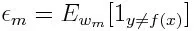

Ha az iterációt 1-ről M-re vesszük m-re, akkor az alábbi kifejezést kapjuk:

Először ki kell választanunk a gyenge osztályozót a legkisebb súlyozott osztályozási hibával azáltal, hogy a gyenge osztályozókat az adatkészletbe illesztjük.

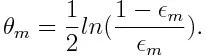

Ezután kiszámítja az m- es gyenge osztályozó súlyát az alábbiak szerint:

A súly minden 50% -nál nagyobb pontosságú osztályozó esetében pozitív. A súly nagyobb lesz, ha az osztályozó pontosabb, és negatívvá válik, ha az osztályozó pontossága kevesebb, mint 50%. A predikció a jel megfordításával kombinálható. A jóslat jelének megfordításával a 40% -os pontosságú osztályozó 60% -os pontossá alakítható. Tehát az osztályozó hozzájárul a végső előrejelzéshez, annak ellenére, hogy rosszabb teljesítményt nyújt, mint a véletlenszerű találgatások. A végső előrejelzés azonban nem járul hozzá, vagy nem kap információt az osztályozótól pontosan 50% -os pontossággal. Az exponenciális kifejezés a számlálóban mindig nagyobb, mint 1, ha a tévesen osztályozott eset pozitív súlyozású osztályozóból származik. Az iteráció után a tévesen besorolt eseteket nagyobb súlyokkal frissítik. A negatív súlyozású osztályozók ugyanúgy viselkednek. De különbség van abban, hogy a jel megfordítása után; a helyes osztályozás eredetileg téves osztályozássá alakulna. A végső előrejelzés kiszámolható az egyes osztályozók figyelembevételével, majd súlyozott előrejelzésük összegének elvégzésével.

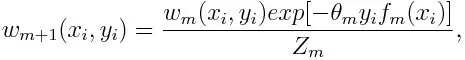

Az egyes adatpontok súlyának frissítése az alábbiak szerint:

Z m itt a normalizációs tényező. Gondoskodik arról, hogy az összes példány súlya összesen egyenlő legyen.

Mire használják az AdaBoost algoritmust?

Az AdaBoost használható az arcfelismeréshez, mivel úgy tűnik, hogy ez a szokásos algoritmus a képek arcfelismerésére. Használ egy elutasító kaszkádot, amely sok rétegű osztályozóból áll. Ha a felismerési ablakot egyetlen rétegben sem ismeri fel arc, akkor azt elutasítják. Az ablak első osztályozója eldobja a negatív ablakot, és a számítási költségeket minimálisra csökkenti. Noha az AdaBoost egyesíti a gyenge osztályozókat, az AdaBoost alapelveit arra is használják, hogy megtalálják a kaszkád minden rétegében a legjobb tulajdonságokat.

Az AdaBoost algoritmus előnyei és hátrányai

Az AdaBoost algoritmus számos előnye, hogy gyors, egyszerű és könnyen programozható. Ezenkívül rugalmas, hogy bármilyen gépi tanulási algoritmussal kombinálható legyen, és nincs szükség a paraméterek hangolására, a T. kivételével. A bináris osztályozáson túlmutató tanulási problémákra is kiterjesztették, és sokoldalú, mivel szöveges vagy numerikusan használható. adat.

Az AdaBoostnak kevés hátránya van, például empirikus bizonyítékokból származik és különösen érzékeny az egyenletes zajra. A túl gyenge osztályozók alacsony marzsokhoz és túlteljesítéshez vezethetnek.

Példa az AdaBoost algoritmusra

Fontos lehet egy példa a hallgatók felvételére az egyetemre, ahol vagy felvételt nyernek, vagy megtagadnak. Itt a mennyiségi és minőségi adatok különböző szempontokból megtalálhatók. Például a felvétel eredménye, amely igen / nem lehet kvantitatív, míg bármely más terület, például a hallgatók készségei vagy hobbija minőségi lehet. Könnyen jön létre a képzési adatok helyes osztályozása, jobb, mint a körülmények esélye, például ha a hallgató egy adott tantárgyon jó, akkor felveszi. De nehéz megtalálni a nagyon pontos előrejelzést, és ekkor a gyenge tanulók kerülnek a képbe.

Következtetés

Az AdaBoost segít az egyes új osztályozók edzéskészletének kiválasztásában, amelyet az előző osztályozó eredményei alapján képztek. Az eredmények kombinálása mellett; meghatározza, hogy mekkora súlyt kell szentelni az egyes osztályozók által javasolt válasznak. Egyesíti a gyenge tanulókat, hogy erős osztályokat hozzon létre az osztályozási hibák kijavítására, ami szintén az első sikeres javító algoritmus a bináris osztályozási problémákhoz.

Ajánlott cikkek

Ez egy útmutató az AdaBoost algoritmushoz. Itt a Koncepció, felhasználások, működés, előnyei és hátrányai példát tárgyaltuk. A további javasolt cikkeken keresztül további információkat is megtudhat -

- Naiv Bayes algoritmus

- Közösségi média marketing interjúkérdések

- Linképítési stratégiák

- Közösségi Média Marketing Platform