Különbség az Apache Storm és az Apache Spark között

Az Apache Storm egy nyílt forráskódú, méretezhető, hibatűrő és elosztott valós idejű számítási rendszer. Az Apache Storm az adatfolyam-feldolgozásra vagy az események feldolgozására összpontosít. Az Apache Storm hibatűrő módszert hajt végre egy számítás elvégzéséhez vagy több számítás bevezetéséhez egy eseményre, amikor az rendszerbe áramlik. Az Apache Spark villámgyors és fürtös számítástechnikai keretrendszer, amelyet nagyszabású adatfeldolgozás gyors számításához terveztek. Az Apache Spark egy elosztott feldolgozó motor, de nem tartozik beépített fürt erőforrás-kezelővel és elosztott tárolórendszerrel. Csatlakoznia kell a választott fürtkezelőt és tárolórendszert.

Bemutatunk többet az Apache Storm vs Apache Spark témáról:

- Az Apache Storm feladat-párhuzamos folyamatos számítási motor. A munkafolyamatokat a Directed Acyclic Graphs (DAG) topológiáknak nevezett grafikáiban határozza meg. Ezek a topológiák addig futnak, amíg a felhasználó le nem állítja őket, vagy helyrehozhatatlan hibát tapasztalnak. Az Apache Storm nem a Hadoop klasztereken fut, hanem a Zookeert és a saját kegyelmi munkáját használja a folyamatok kezelésére. Az Apache Storm képes olvasni és írni fájlokat a HDFS-be.

- Az Apache Storm integrálódik a már használt sorbaállítási és adatbázis-technológiákhoz. A Storm-topológia adatfolyamokat vesz igénybe, és ezeket a folyamatokat tetszőlegesen összetett módon dolgozza fel, a patakok megoszlása a számítás minden egyes fázisa között, ha szükséges. Az Apache Storm a táblázatokon és folyamokon alapul. Alapvetően egy adaglap az, ami az Ön adatai és hogyan vannak felépítve.

- Az Apache Spark keretrendszere Spark Core-ból és könyvtárakból áll. A Spark core végrehajtja és kezeli a munkánkat azzal, hogy zökkenőmentes élményt nyújt a végfelhasználó számára. A felhasználónak munkát kell benyújtania a Spark core-hez, és a Spark core gondoskodik a további feldolgozásról, végrehajtásról és a felhasználónak való visszatérésről. A Spark Core API különféle szkriptnyelveken, például Scala, Python, Java és R.

- Az Apache Spark alkalmazásban a felhasználó az Apache Storm használatával átalakíthatja a nem strukturált adatokat, amikor azok a kívánt formátumba áramlanak. Csatlakoznia kell a választott fürtkezelőt és tárolórendszert.

- Az Apache YARN vagy a Mesos az Apache Spark fürtkezelőjéhez választhat.

- Az Apache Spark erőforráskezelőjéhez választhat a Hadoop elosztott fájlrendszerét (HDFS), a Google felhőalapú tárolását, az Amazon S3-ot, a Microsoft Azure-t.

- Az Apache Spark egy adatfeldolgozó motor kötegelt és streaming módokban, amely SQL lekérdezéseket, grafikonfeldolgozást és gépi tanulást tartalmaz.

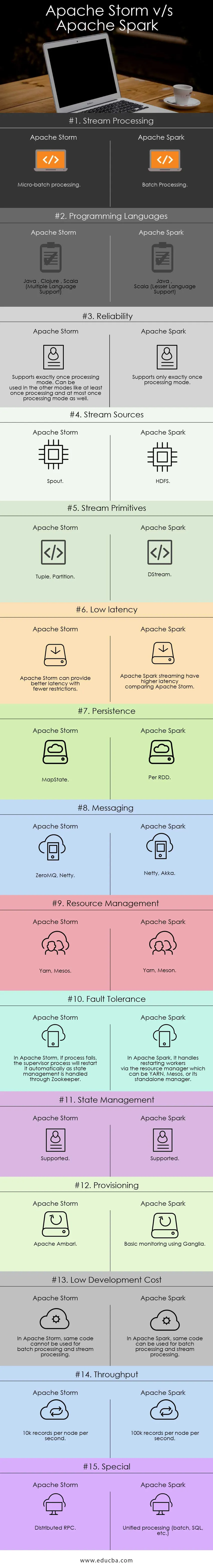

Összehasonlítás az Apache Storm és az Apache Spark között (Infographics):

Főbb különbségek az Apache Storm és az Apache Spark között:

Az alábbiakban felsoroljuk a pontok listáját, írjuk le az Apache Storm és az Apache Spark közötti főbb különbségeket:

- Az Apache Storm feladat-párhuzamos számításokat végez, míg az Apache Spark adat párhuzamos számításokat végez.

- Ha a munkavállalói csomópont meghiúsul az Apache Storm alkalmazásban, a Nimbus a munkavállalók feladatát a másik csomóponthoz rendeli, és a sikertelen csomóponthoz küldött összes időt időkorlátozza, és így automatikusan lejátssza, míg az Apache Sparkban, ha a munkavállalói csomópont meghibásodik, akkor a rendszer újra kiszámolhatja a A bemeneti adatok maradék másolata és az adatok elveszhetnek, ha az adatokat nem replikálják.

- Az Apache Strom kézbesítési garanciája egy biztonságos adatforrástól függ, míg az Apache Spark esetében a HDFS által támogatott adatforrás biztonságos.

- Az Apache Storm egy adatfolyam-feldolgozó motor valós idejű adatfolyam-feldolgozáshoz, míg az Apache Spark általános célú számítógépes motor.

Az Apache Storm jellemzői:

- Hibatűrés - ha a munkavállalói szálak meghalnak, vagy egy csomópont lemerül, a dolgozókat automatikusan újraindítják

- Skálázhatóság - Nagyon skálázható, a Storm a növekvő terhelés mellett is képes fenntartani a teljesítményt erőforrások lineáris hozzáadásával, ahol akár csomópontonként másodpercenként akár egymillió 100 bájt üzenet átviteli sebessége érhető el

- Várakozási idő - A Storm az adatok frissítését végzi, és a végponttól-végig történő válaszadás másodpercekben vagy percben a problémától függ. Nagyon alacsony késleltetésű.

- Könnyű használat a rendszer telepítésében és üzemeltetésében.

- Integrálva a Hadoop-nal a nagyobb teljesítmény eléréséhez

- Könnyen megvalósítható, és bármilyen programozási nyelvbe integrálható

- Az Apache Storm nyílt forráskódú, robusztus és felhasználóbarát. Használható lenne kisvállalatokban és nagyvállalatokban is

- Hihetetlenül gyorsan valósidejű adatfolyam-feldolgozást tesz lehetővé, mert hatalmas erővel bír az adatok feldolgozása.

- Az Apache Storm operatív intelligenciával rendelkezik.

- Az Apache Storm garantált adatfeldolgozást biztosít még akkor is, ha a fürt bármelyik csatlakoztatott csomópontja meghal vagy az üzenetek elvesznek

Az Apache Spark tulajdonságai:

- Sebesség: az Apache Spark segít egy alkalmazás futtatásában a Hadoop-fürtben, akár 100-szor gyorsabb memóriával, és 10-szer gyorsabb, ha a lemezen fut.

- Valósidejű feldolgozás: Az Apache-szikra képes valós idejű adatfolyamokra.

- Használhatóság : Az Apache Spark több nyelvet támogat, mint például a Java, a Scala, a Python és az R

- Lusta értékelés: Az Apache Spark esetében az átalakulások lusta jellegűek. Eredményt ad, ha a meglévőből RDD-t alakít ki.

- Integráció a Hadoop-tal: Az Apache Spark önállóan és a Hadoop YARN Cluster Manager-en is futhat, és így képes olvasni a meglévő Hadoop-adatokat.

- Hibatolerancia: Az Apache Spark az RDD-koncepció segítségével hibatűrést biztosít. A Spark RDD-ket úgy tervezték, hogy kezeljék a fürtben lévő bármely munkavállalói csomót.

Apache Storm vs Apache Spark összehasonlító táblázat

Fontos tárgyakat tárgyalok, és különbséget teszek az Apache Storm és az Apache Spark között.

| Apache Storm | Apache Spark | |

| Patak feldolgozása | Mikro-szakaszos feldolgozás | Kötegelt feldolgozás |

| Programozási nyelvek | Java, Clojure, Scala (Többnyelvű támogatás) | Java, Scala (kisebb nyelvi támogatás) |

| Megbízhatóság | Pontosan egyszeri feldolgozási módot támogat. Más üzemmódokban is használható, például legalább egyszer feldolgozás és legfeljebb egyszer feldolgozási mód is | Csak pontosan egyszer támogatja a feldolgozási módot |

| Patak forrásai | Kilövell | HDFS |

| Patak primitívumok | Tuple, válaszfal | DStream |

| Alacsony késleltetés | Az Apache Storm jobb késést biztosít kevesebb korlátozással | Az Apache Spark adatfolyamok késése nagyobb, mint az Apache Storm |

| Kitartás | MapState | RDD-nként |

| Üzenetek | ZeroMQ, Netty | Netty, Akka |

| Erőforrás menedzsment | Fonal, Mesos | Fonal, Meson |

| Hibatűrés | Az Apache Storm esetén, ha a folyamat sikertelen, a felügyeleti folyamat automatikusan újraindítja, mivel az állapotkezelést a Zookeeper kezeli | Az Apache Sparkban kezeli a munkavállalók újraindítását az erőforrás-kezelőn keresztül, amely lehet YARN, Mesos vagy önálló kezelője. |

| Állami menedzsment | támogatott | támogatott |

| Ellátása | Apache Ambari | Alapvető figyelés a Ganglia segítségével |

| Alacsony fejlesztési költség | Az Apache Storm alkalmazásban ugyanaz a kód nem használható kötegelt feldolgozásra és adatfolyam feldolgozásra | Az Apache Spark esetében ugyanaz a kód használható kötegelt feldolgozásra és adatfolyam feldolgozásra |

| áteresztőképesség | 10 k rekord / csomópont / másodperc | 100 k rekord / csomópont / másodperc |

| Különleges | Elosztott RPC | Egységes feldolgozás (kötegelt, SQL stb.) |

Következtetés - Apache Storm vs Apache Spark:

Az Apache Storm és az Apache Spark kiváló megoldások, amelyek megoldják a streaming bevitel és átalakítás problémáját. Az Apache Storm és az Apache Spark egyaránt részei lehetnek a Hadoop-fürtnek az adatok feldolgozásához. Az Apache Storm egy valós idejű adatfolyam-feldolgozási megoldás. A Storm azonban a korlátozott erőforrások miatt nagyon összetett a fejlesztők számára az alkalmazások fejlesztésére.

Az Apache Storm többnyire stream feldolgozásra használható. De az iparnak általánosított megoldásra van szüksége, amely megoldhatja az összes típusú problémát. Például kötegelt feldolgozás, interaktív adatfeldolgozás, valamint iteratív feldolgozás. Tehát az Apache Spark reflektorfénybe kerül, amely egy általános célú számítási motor. Ez az oka annak, hogy az Apache Spark inkább összehasonlítja az informatikai szakemberek más eszközöit. Az Apache Spark különféle típusú problémákat képes kezelni. Ezen kívül az Apache Spark túlságosan egyszerű a fejlesztők számára, és nagyon jól integrálható a Hadoopba. Az Apache Spark rugalmasságot ad a különböző nyelveken és környezetekben történő munkavégzéshez.

Ajánlott cikk

Ez egy útmutató az Apache Storm vs Apache Spark-nak, azok jelentésének, a fej közötti összehasonlításnak, a legfontosabb különbségeknek, az összehasonlító táblázatnak és a következtetéseknek. A következő cikkeket is megnézheti további információkért -

- Iaas vs Azure Pass - különbségek, amelyeket tudnod kell

- Apache Hadoop vs Apache Spark | A tíz legjobb összehasonlítás, amit tudnod kell!

- 7 Csodálatos útmutató az Apache Sparkról (útmutató)

- A legjobb 15 dolog, amelyet tudnia kell a MapReduce vs Spark termékről

- Hadoop vs Apache Spark - Érdekes dolgok, amelyeket tudnod kell